행렬 matrix

- 수 들의 m 행 n 열 모임

전치 행렬 transpoise matrix

- 행렬 A의 (i, j)성분들을 (j, i)성분으로 바꾼 행렬

대각 행렬 diagonal matrix

- 주 대각 성분 principal diagonal component 이외의 모든 성분들이 0 인 행렬

단위 행렬 identity matrix

- 주 대각 성분이 1인 대각 행렬들

대칭 행렬 symmetric matrix

- 행렬 A가 A의 전치행렬과 같은 경우

교대 행렬 antisymmetric matrix

- 행렬 A가 A의 전치 행렬에 -를 곱한 것과 동일한 경우. 행렬 A는 교대 행렬

양 확정 행렬과 양 세미확정 행렬

- 대칭 행렬 A가 주어질때, 모든 n차원 벡터에서

- 다음 과 같은 경우 행렬 A는 양 확정 행렬 positive deifinite matrix

- 아래와 같은 경우 행렬 A는 양 세미확정 행렬 positive semidefinite matrix

역행렬과 특이행렬

- 행렬 A가 주어질때, AB = I를 만족하는 행렬 B가 존재하는 경우

- 정칙행렬 비특이행렬 nonsingular matrix : 행렬 A

- 역행렬 inverse matrix : 행렬 B

+ 비 정칙 행렬, 특이 행렬 singular matirx : 정칙 행렬이 아닌 행렬. 즉, 역행렬이 존재하지 않는 행렬

행렬의 랭크

- 선형 독립인 벡터의 개수

- 행렬 A의 벡터 2개가 선형 독립이라면 -> rank(A) = 2

- 행렬 A의 벡터 5개가 선형 독립이라면 -> rank(A) = 5

'수학 > 선형대수, 최적화' 카테고리의 다른 글

| 선형대수 - 6. 고유치와 고유 벡터 (0) | 2020.07.16 |

|---|---|

| 선형대수 - 5. 함수와 변환 (0) | 2020.07.16 |

| 선형대수 - 3. 기저와 노름 (0) | 2020.07.16 |

| 선형대수 - 2. 벡터 공간과 부분 공간, 선형 결합 (0) | 2020.07.16 |

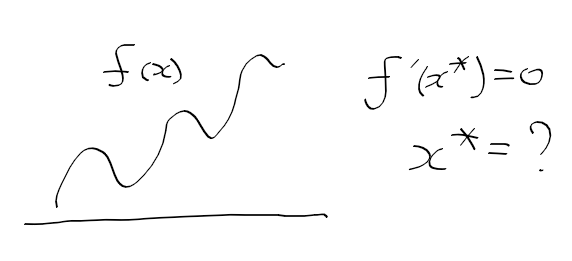

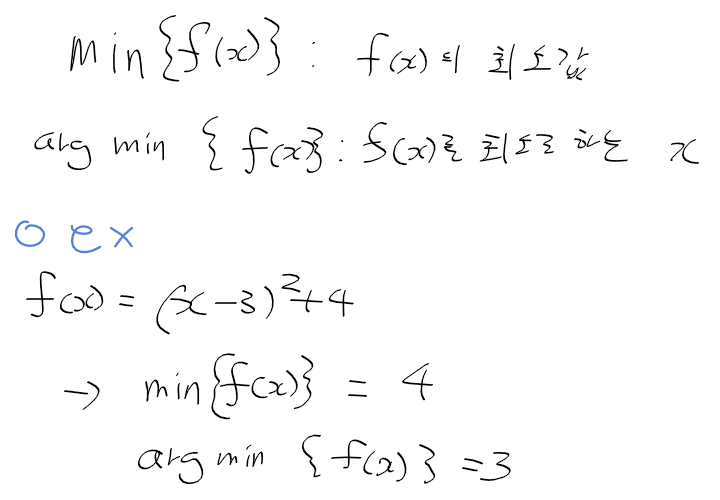

| 최적화 - 1. 최적화와 관련 개념들 (0) | 2020.07.16 |