Improving Model Performance (C3W1L01)

- 머신러닝 전략 : 머신러닝 알고리즘의 구성

- 빠르고 효율적인 머신러닝 모델을 만드는 방법 -> 전략을 알아보자.

동기부여를 위한 예시

- 고양이 분류 작업에서 90% 정확도로 사용하는데 충분한 성능을 얻었다. 어떻게 더 향상시킬수 있을까?

- 신경망을 향상시키기 위한 방법들

1. 더 많은 학습데이터를 사용하자.

2. 다양한 훈련 셋을 모아보자 : 다양한 자세의 고양이 이미지나 다른 종류의 고양이

3. 경사하강법으로 더 길게 학습해보자

4. 경사 하강대신에 아담 최적화기를 사용해보자

5. 신경망을 더 키워보거나 줄여보자

6. 드롭 아웃을 해보자

7. L2 규제를 추가해보자

8. 신경망 아키텍처를 변경해보자 ex. 활성화 함수, 은닉층 유닛 개수

=> 길게 학습한다고 해도 더이상 성능 향상이 이뤄지지 않을때도 있다. 위와 같은 방법들을 시도해 볼 수 있음.

'컴퓨터과학 > 딥러닝 AI Andrew Ng' 카테고리의 다른 글

| C1W4L05 Building Blocks of a Deep Neural Network (0) | 2021.04.29 |

|---|---|

| C1W4L04 Why Deep Representations? (0) | 2021.04.29 |

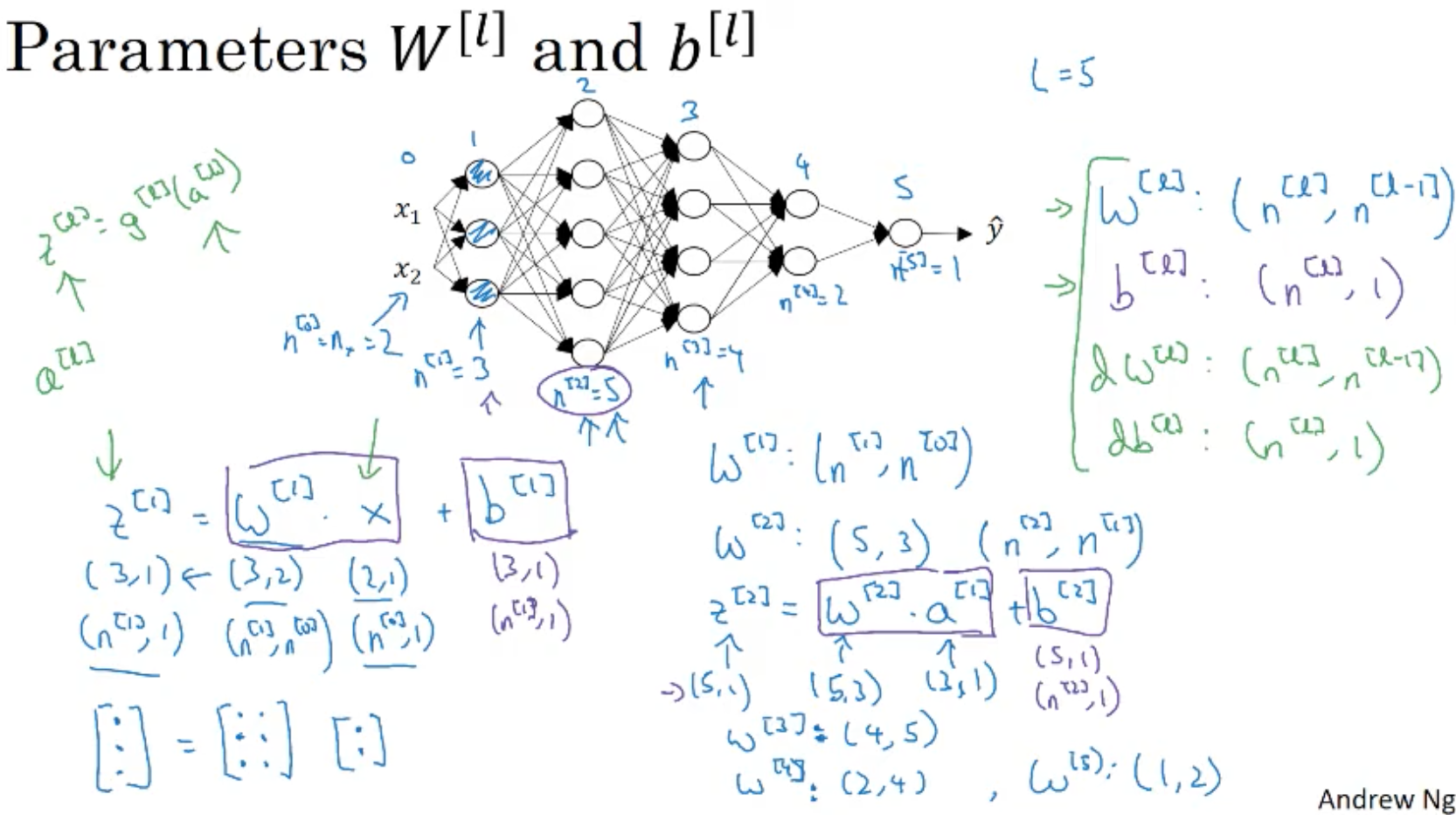

| C1W4L03 Getting Matrix Dimensions Right (0) | 2021.04.29 |

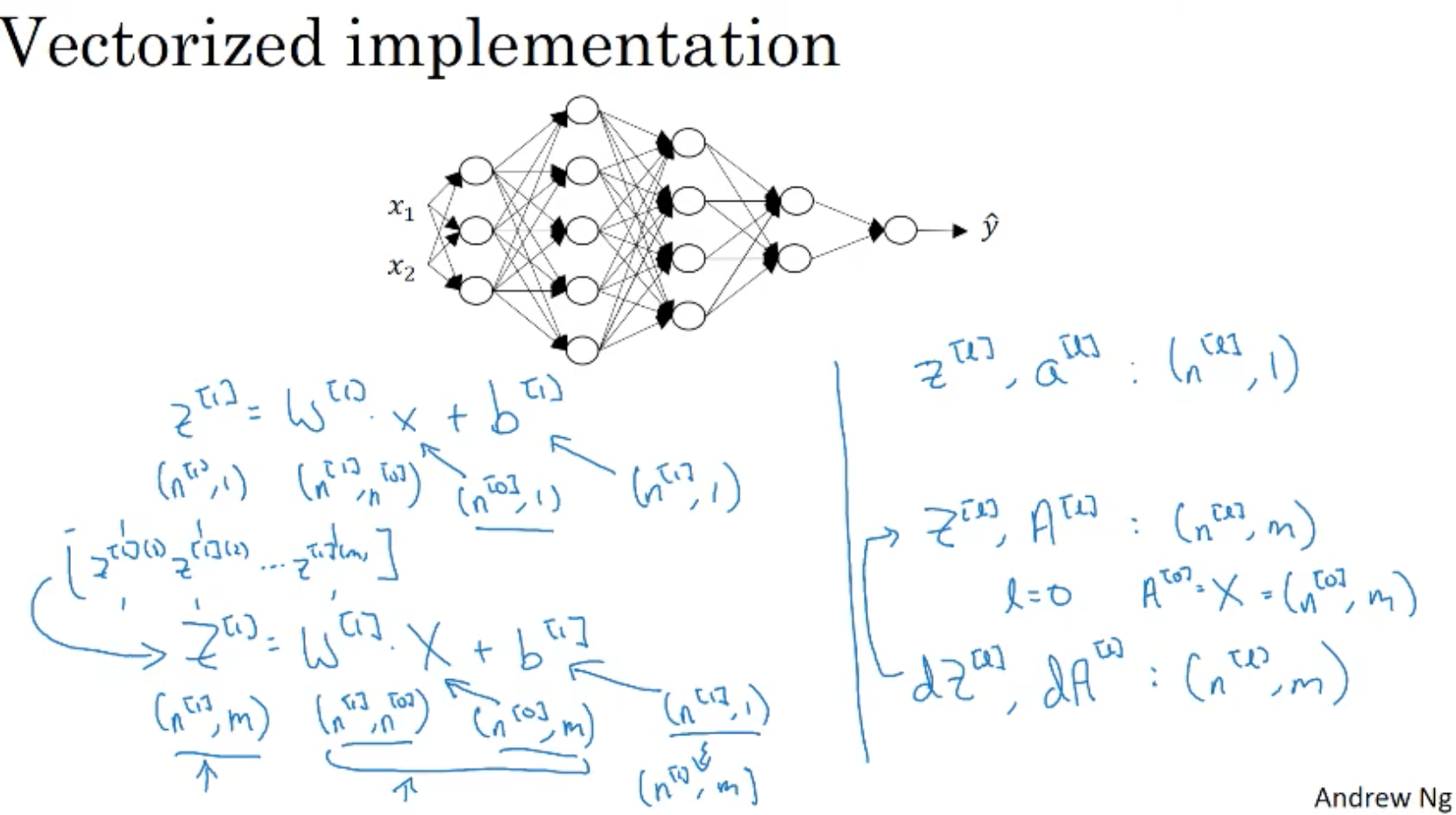

| C1W4L02 Forward Propagation in a Deep Network (0) | 2021.04.29 |

| C1W4L01 Deep L-Layer Neural Network (0) | 2021.04.29 |