확률 probability

- 불확실한 가능성을 측정한 정도

확률과 도박문제

1. 상황 : 승률이 0.5인 도박, 도박사 A, B가 각 32피스톨(화폐)를 걸고 시작

2. A가 2번이기고, B가 1번 이김 -> 중지

=> 어떻게 해야 공평할까?

3. 2번이긴 A에게 64 * 2/3 = 42.7 , 1번이긴 B 64 * 1/3 = 21.3에게 주는것은 불공평(페르마)

4. B가 돈을 다 받으려면 2번 이겨야함 -> 확률 : 1/4

5. A가 돈을 다받으려면 1번만 이기면 됨 -> 확률 : 1 - (1/4) <- B가 우승할 확률

6. 결론 : A = 64 * 3/4, B = 64 * 1/4

=> 기댓값

동전 확률의 상대 도수 relative frequency 적 정의

- 동전의 앞면이 나올 확률 1/2

- 동전이 여러번 던질때 앞면이 나올 확률을 아래와같이 상대도수적으로 정리 가능

확률의 상대 도수적 정의

- n번 시행(도수)했을떄 사건 A가 발생한 확률 P(A)는 A가 a만큼 발생한 경우 아래와 같이 정의

기하학적 확률

- 그동안 안 확률들은 모든 사건들이 일어날 확률이 같다고 가정하고 다룸

=> 발생 가능한 사건이 3개가 있다면, 각 사건들의 발생 가능성은 1/3이라고 보는것

- 하지만 표본 공간에서 많이 차지하는 사건이 있고, 적게 차지하는 경우도 많음

- 기하학적 확률 : 전체 공간의 면적을 S, 사건 A의 면적을 a라 할때 기하학적 확률은 아래와 같이 정의

주관주의 확률 예시 degree of belief

- 두 줄이 있을때 내가 선 줄과 다른 줄 둘중 하나가 먼저 줄어들 확률은 0.5, 0.5로 반반

- 줄이 10개가 있다면 내 줄이 가장 먼저 끝날 확률은 1/10. -> 내가 늦어질 확률은 9/10

=> 주관적 확률과 과학적 확률 사이에 차이가 존재. 비합리적인 행동을 하게됨.

확률의 종류

- 크게 주관적 확률과 객관적 확률(상대도수적 확률, 기하학적 확률)로 구분 가능

1. 상대도수 relative frequency, 빈도주의적 확률 : 전체 사건 발생 횟수 중에 몇번 발생했는가?

2. 기하학적 확률 geometric : 해당 사건이 전체 공간에서 얼마나 차지하는가?

3. 주관주의 확률 degree of belief : 객관적으로 구할수 없으나 주관적으로 생각하는 확률

'수학 > 공업수학, 확률' 카테고리의 다른 글

| 확률 - 3. 조건부 확률 (0) | 2020.08.11 |

|---|---|

| 확률 - 2. 고전적 확률과 공리적 확률 (0) | 2020.08.07 |

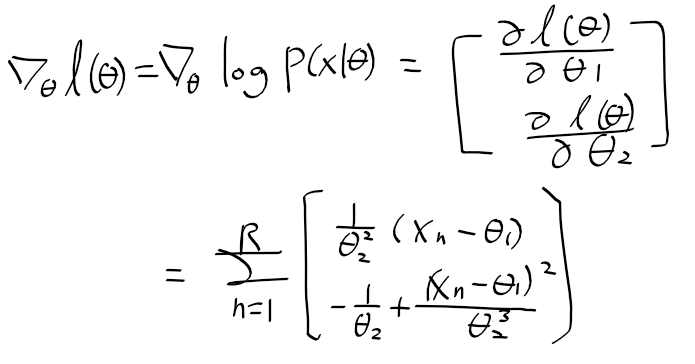

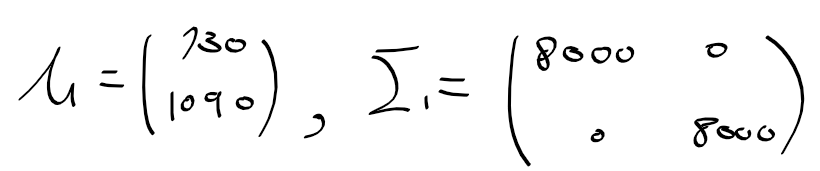

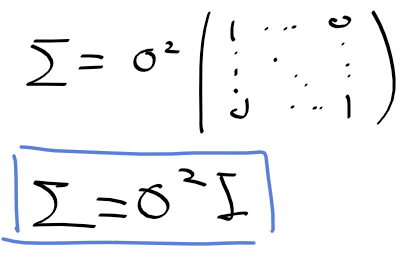

| 통계 - 14. 최우추정법을 이용한 확률밀도함수 추정 (0) | 2020.08.04 |

| 통계 - 13. 판별함수 (0) | 2020.08.04 |

| 통계 - 12. 베이즈 위험을 이용한 결정 규칙들과 다중 클래스 결정 규칙 (0) | 2020.08.04 |