최적화의 기본 개념

- 특정 데이터가 주어질때, 이로 부터 필요한 값들을 추출이 필요

ex. 컴퓨터 비전, 머신러닝

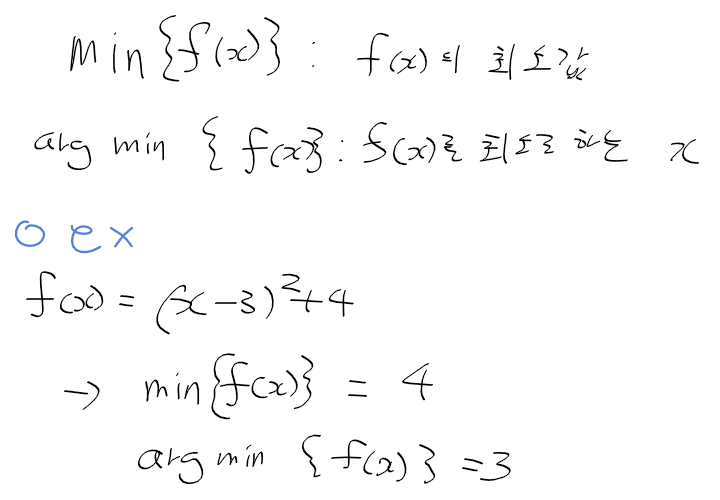

- 목적 함수 objective function or 비용 함수 cost function : 이 값들을 구하기 위한 함수

최적화란?

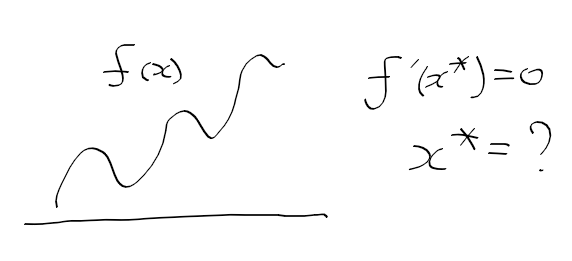

- 목적 함수를 이용하여 f(x*) <= f(x)인 x*를 찾는 일

목적 함수의 판별 어려움

- 목적 함수로 구한 최소자가 전역 최소자인지, 목적 최소자인지 판별하기 힘듬

최소자를 찾는 방법

- 초기 지점 x0를 설정하고 초기 지점 보다 낮은 x1을 반복해서 찾음

- 하강방향 설정 -> 다음 지점 선택 -> 반복

=> 지역 최소자를 찾음

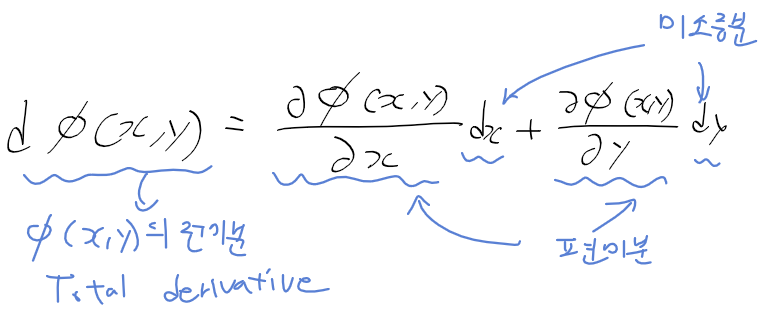

목적함수, 최소자 정리

최적화 방법들

1. 경사 하강법 gradient descent

2. 직선 탐색 line search

3. 황금 분할 탐색 gloden section search

4. 뉴턴 방법

5. 비선형 최소 자승 방법

6. 라그랑주 승수를 이용한 최적화

'수학 > 선형대수, 최적화' 카테고리의 다른 글

| 최적화 - 10. 직선 탐색 (0) | 2020.07.26 |

|---|---|

| 최적화 - 9. 경사를 이용한 하강방향 탐색 - 경사하강법 (0) | 2020.07.26 |

| 최적화 - 7. 컨벡스 함수 (0) | 2020.07.22 |

| 최적화 - 6. 다변수 함수의 테일러 급수 정리와 레벨 집합 (0) | 2020.07.22 |

| 최적화 - 5. 헤시안 행렬 (0) | 2020.07.21 |