mpu6050 이론

- 센서 레지스터 내용을 잘 정리했더라

ref : https://blog.naver.com/mokhwasomssi/221801280305

아두이노 cc

- mpu 6050 사용 예제 일부

ref : https://create.arduino.cc/projecthub/Raushancpr/mpu6050-configuration-with-arduino-1a3dcf

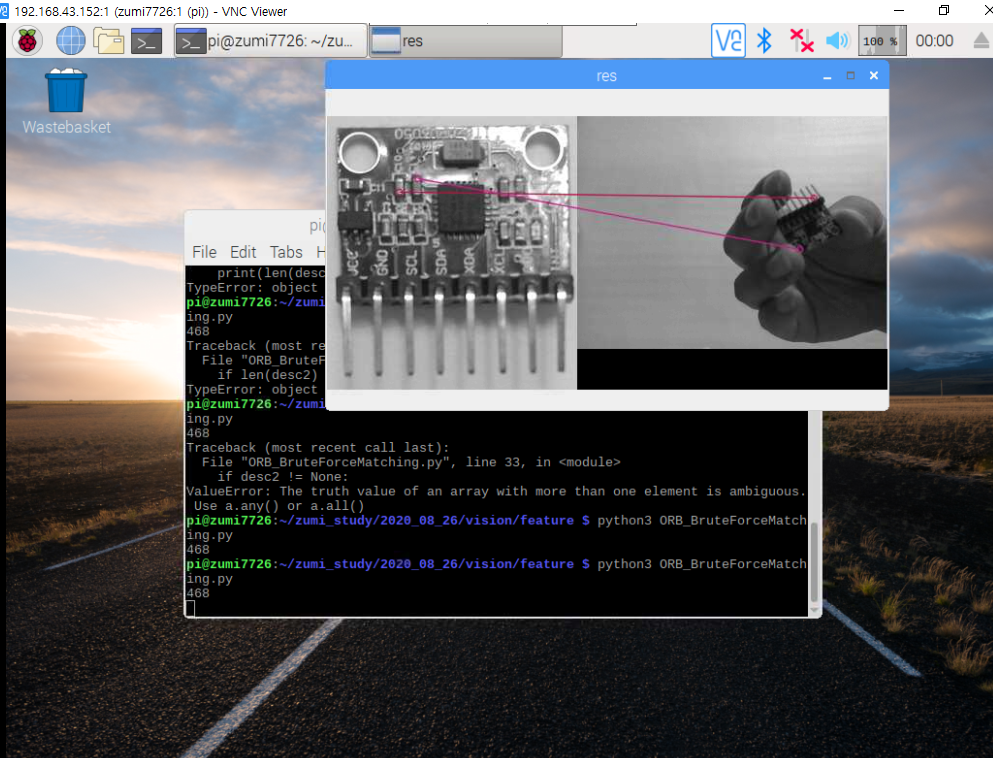

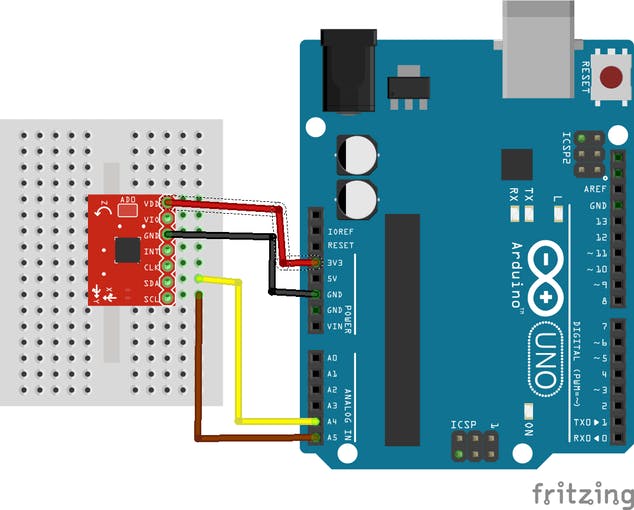

Fritzing file that shows how to wire the GY-521 breakout board to an Arduino Uno.In this tutorial we will make use only of the first four pins: VCC, GND, SDA, and SCL.

-> 위 프리징 이미지는 GY-521 보드(mpu 6050 센서 내장)와 아두이노 우노 연결 예시를 보여줌

First, we connect the module’s VCC to the Arduino’s 5V pin. Then, the module’s GND is connected to one of the Arduino’s GND pins.Next, we have to set up the I2C connection between the module and the Arduino.

-> VCC는 아두이노 5v, GND는 아두이노 GND, 나머지 SDA와 SCL로 아두이노와 i2c 연결

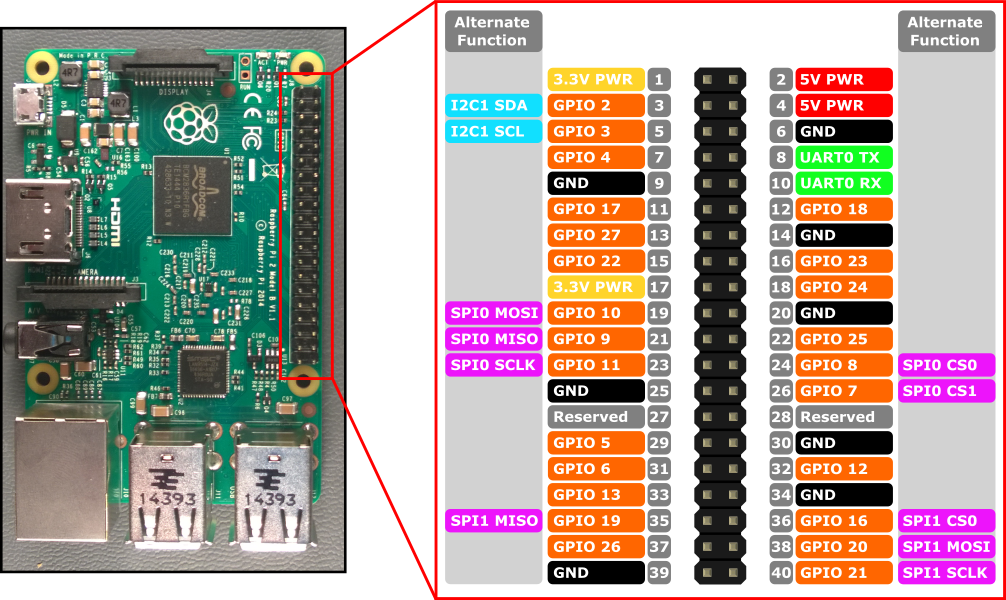

Most Arduino Uno variants have an SCL and SDA pin. If you have such an Arduino Uno, just connect SCL to SCL and SDA to SDA.

-> 모듈 SCL은 아두이노 SCL, 모듈 SDA는 아두이노 SDA와 연결해야함

If you can’t find an SCL and SDA pin on your Arduino, you have to use other pins. Unfortunately, you cannot use just any pin.

-> 아두이노에 별도 SCL, SDA 핀이없으니 대신 다른 핀 사용

For each type of Arduino, SCL and SDA are tied to different pins:Arduino Uno, Arduino Ethernet, Arduino Nano: A4 (SDA), A5 (SCL)Arduino Mega2560: 20 (SDA), 21 (SCL)Arduino Leonardo: 2 (SDA), 3 (SCL)Arduino Due: 20 (SDA), 21 (SCL)So, if you have an Arduino Uno without SCL and SDL pins, then connect the Arduino’s A4 pin to the module’s SDA pin. Next, connect the Arduino’s A5 pin to the module’s SCL pin.

-> (메가2560, 레오나르도, 듀오 내용은 뺌)

우노 보드에 사용시 SDA핀을 우노 A4핀에 연결

SCL은 우노의 A5핀에 연결

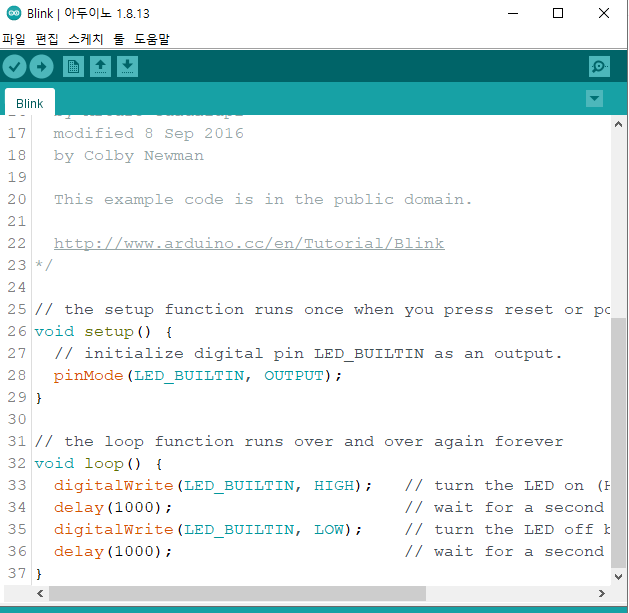

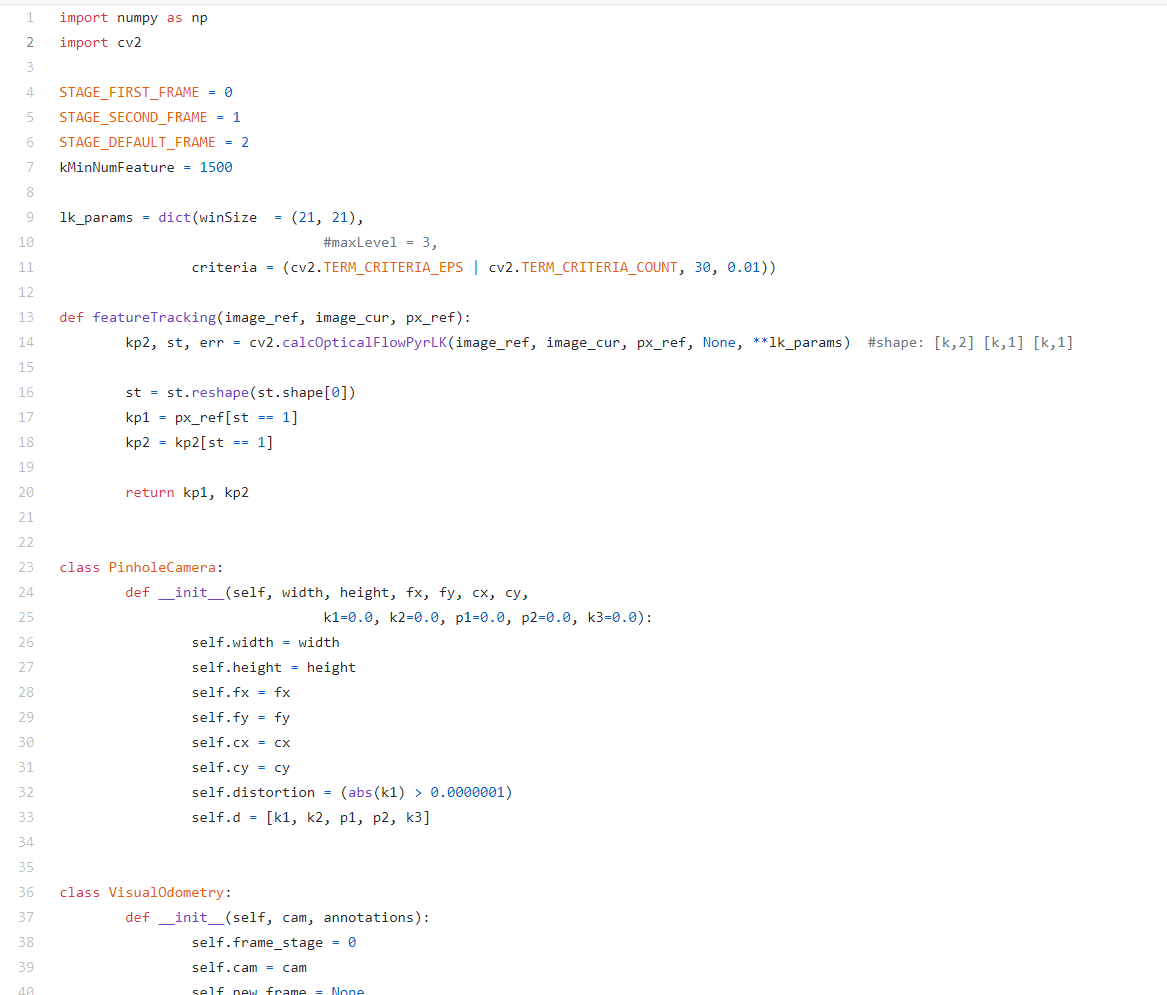

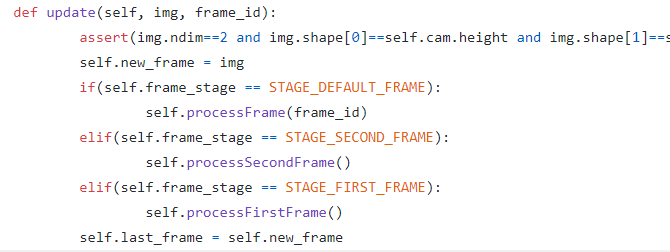

Example source code:We make use of the Arduino platform’s in-built library (Wire) to establish an I2C connection between the Arduino Uno and the GY-521 sensor. At the beginning of our source code, the Wire library’s header file is included.

-> 아두이노에서 제공하는 "Wire.h" 라이브러리로 I2C 통신 수행. 해더 파일로 포함시킴

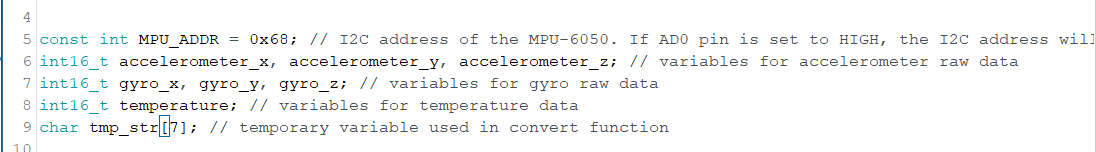

Next, we define and declare some variables.

-> 사용할 변수 선언, 정의

- MPU6050 주소, 센서 값 담을 변수, 임시 문자열 변수

Then, a convert-function is defined. The convert-function makes sure that all sensor values have the same width when they are printed out to the serial monitor later.

-> int16 타입의 센서 값을 문자열 출력하도록 변환 함수 정의

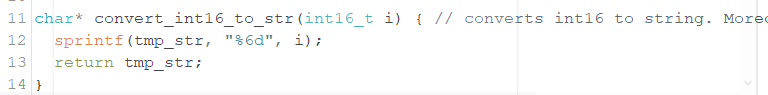

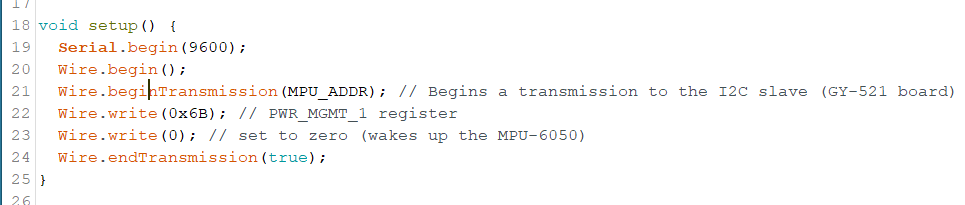

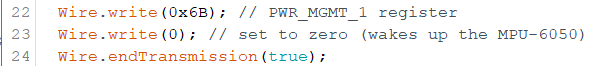

In the setup function, a serial connection is established. Moreover, we start our first I2C transmission to the GY-521 board to wake it up from sleep mode.

-> 시리얼 통신을 시작하고,

보드와 I2C 통신도 시작.

* I2C 통신 데이터는 8비트 길이

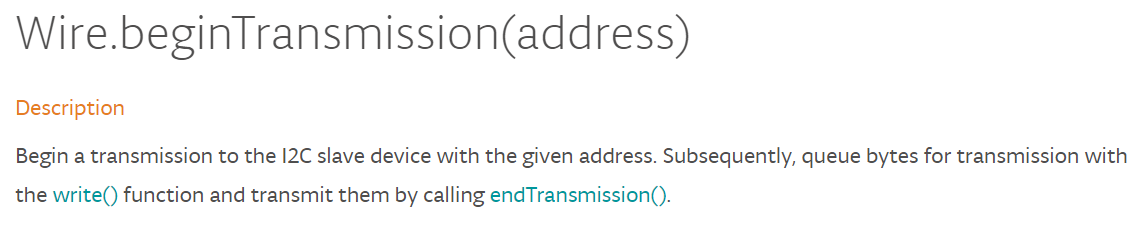

wire.beginTransmission(addr)

-> I2C 슬레이브 장치의 주소로 통신 시작

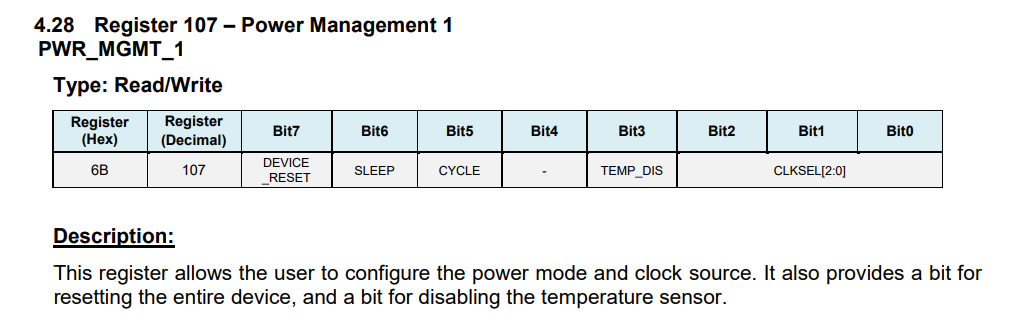

wire.write(0x6B)

wire.write(0)

-> 0x6B 번지에 0 쓰기 => GY-521 보드에 전원인가

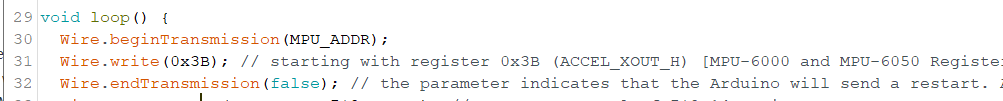

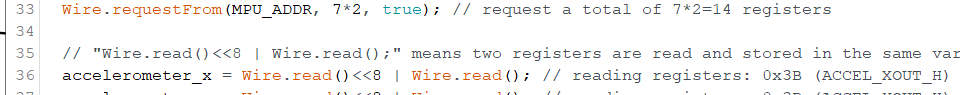

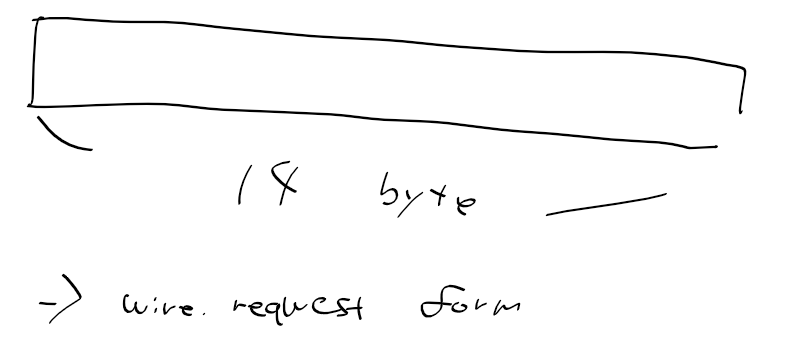

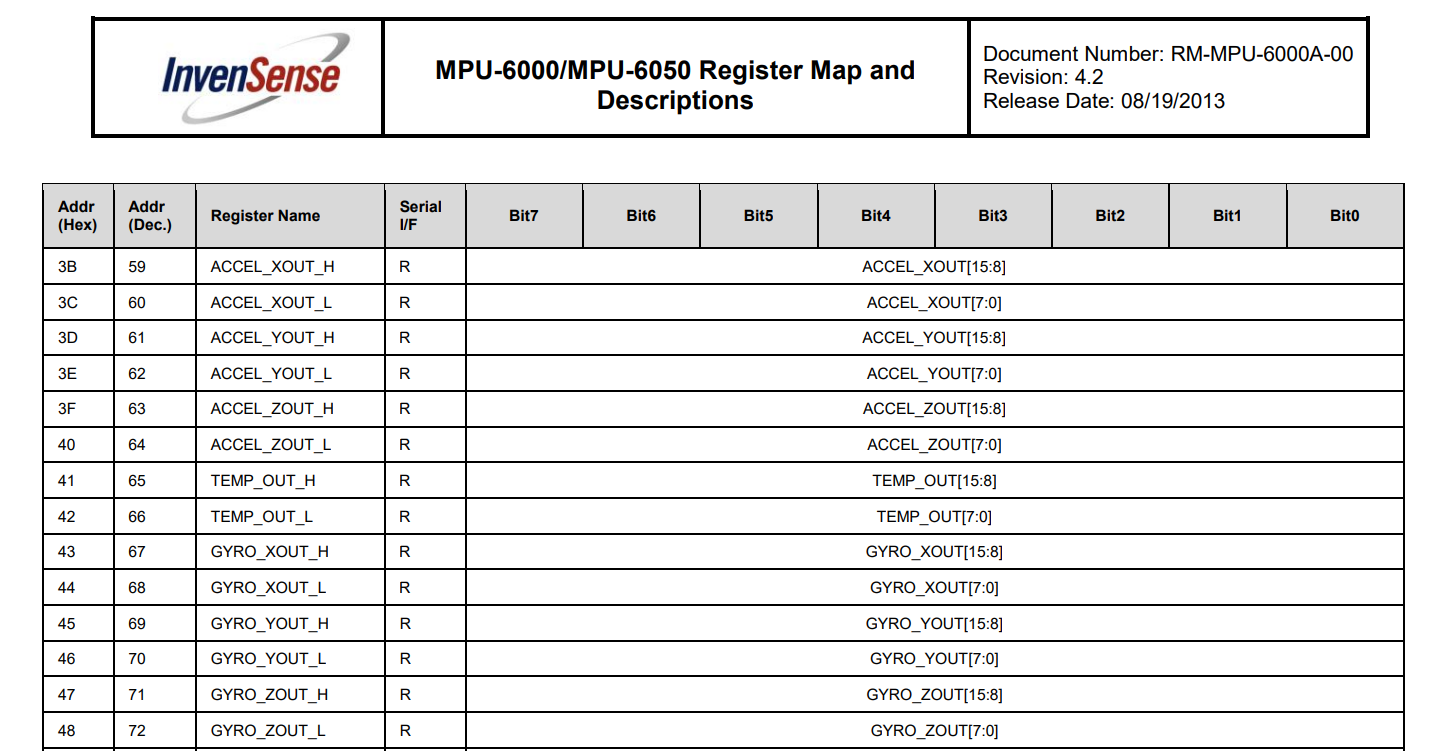

The MPU-6050 has many registers which can be read. Fourteen of these registers contain the sensor values that we need. As a first step, we tell the GY-521 module where we are going to start reading (“Wire.write(0x3B);”). Then, we request to read 14 registers (“Wire.requestFrom(MPU_ADDR, 7*2, true);”).

-> 0x3B 부터 읽음.

ACC X의 H 값은 0x3B에서 읽을수 있기 때문

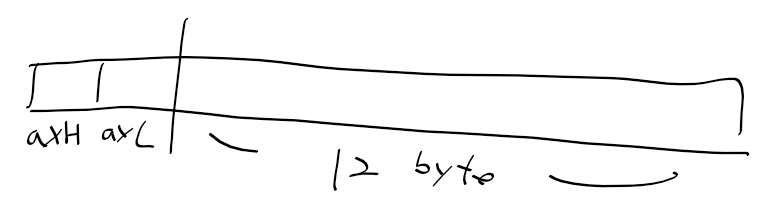

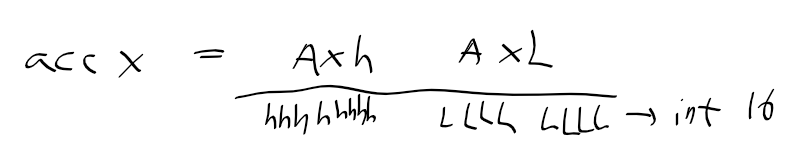

If you are wondering, why 14 registers are read instead of 7 registers, the reason is quite simple: Each sensor value has a size of 2 byte. As each register has a size of one byte, a single sensor value must be retrieved by accessing two registers. The first register contains the so-called “high byte” and the second register contains the “low byte”.

-> 레지스터가 7개이나 14레지스터를 읽는 이유. 한 센서 값은 2바이트로 되서(첫쨰는 하이바이트, 둘째는 로바이트).

Wire.requestFrom(MPU_ADDR, 7*2, true); // request a total of 7*2=14 registers

-> 14바이트 요청

첫 두바이트는 acc x(H, L)

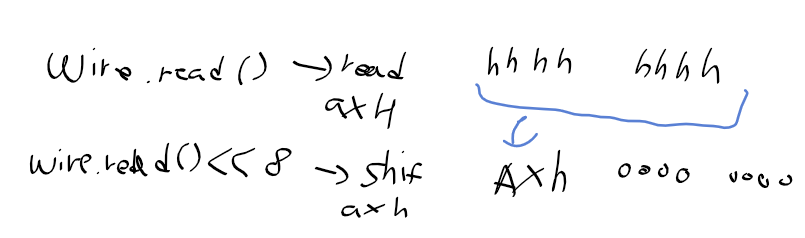

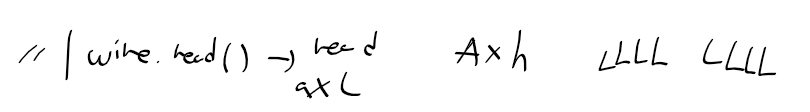

wire.read()로 우선 acc x H 읽기

이후 시프트해서 acc x L는 0으로

Ax H를 시프트 후, wire.read()하여 acc x L값을 읽고 or연산

=> 가속도 X값 완성

acc X는 16비트(2바이트)로 int16에 담음

* MPU6050 레지스터맵 - ACC + TEMP + GYRO 번지

Next, all values are retrieved and printed out to the serial connection. At the end of the loop function, a delay of one second is added in order to avoid flooding the serial monitor with messges

-> 직렬 통신으로 출력을 마치면, 너무 빨리 출력되지 않도록 딜레이 줌

#include "Wire.h" // This library allows you to communicate with I2C devices.

const int MPU_ADDR = 0x68; // I2C address of the MPU-6050. If AD0 pin is set to HIGH, the I2C address will be 0x69.

int16_t accelerometer_x, accelerometer_y, accelerometer_z; // variables for accelerometer raw data

int16_t gyro_x, gyro_y, gyro_z; // variables for gyro raw data

int16_t temperature; // variables for temperature data

char tmp_str[7]; // temporary variable used in convert function

char* convert_int16_to_str(int16_t i) { // converts int16 to string. Moreover, resulting strings will have the same length in the debug monitor.

sprintf(tmp_str, "%6d", i);

return tmp_str;

}

void setup() {

Serial.begin(9600);

Wire.begin();

Wire.beginTransmission(MPU_ADDR); // Begins a transmission to the I2C slave (GY-521 board)

Wire.write(0x6B); // PWR_MGMT_1 register

Wire.write(0); // set to zero (wakes up the MPU-6050)

Wire.endTransmission(true);

}

void loop() {

Wire.beginTransmission(MPU_ADDR);

Wire.write(0x3B); // starting with register 0x3B (ACCEL_XOUT_H) [MPU-6000 and MPU-6050 Register Map and Descriptions Revision 4.2, p.40]

Wire.endTransmission(false); // the parameter indicates that the Arduino will send a restart. As a result, the connection is kept active.

Wire.requestFrom(MPU_ADDR, 7*2, true); // request a total of 7*2=14 registers

// "Wire.read()<<8 | Wire.read();" means two registers are read and stored in the same variable

accelerometer_x = Wire.read()<<8 | Wire.read(); // reading registers: 0x3B (ACCEL_XOUT_H) and 0x3C (ACCEL_XOUT_L)

accelerometer_y = Wire.read()<<8 | Wire.read(); // reading registers: 0x3D (ACCEL_YOUT_H) and 0x3E (ACCEL_YOUT_L)

accelerometer_z = Wire.read()<<8 | Wire.read(); // reading registers: 0x3F (ACCEL_ZOUT_H) and 0x40 (ACCEL_ZOUT_L)

temperature = Wire.read()<<8 | Wire.read(); // reading registers: 0x41 (TEMP_OUT_H) and 0x42 (TEMP_OUT_L)

gyro_x = Wire.read()<<8 | Wire.read(); // reading registers: 0x43 (GYRO_XOUT_H) and 0x44 (GYRO_XOUT_L)

gyro_y = Wire.read()<<8 | Wire.read(); // reading registers: 0x45 (GYRO_YOUT_H) and 0x46 (GYRO_YOUT_L)

gyro_z = Wire.read()<<8 | Wire.read(); // reading registers: 0x47 (GYRO_ZOUT_H) and 0x48 (GYRO_ZOUT_L)

// print out data

Serial.print("aX = "); Serial.print(convert_int16_to_str(accelerometer_x));

Serial.print(" | aY = "); Serial.print(convert_int16_to_str(accelerometer_y));

Serial.print(" | aZ = "); Serial.print(convert_int16_to_str(accelerometer_z));

// the following equation was taken from the documentation [MPU-6000/MPU-6050 Register Map and Description, p.30]

Serial.print(" | tmp = "); Serial.print(temperature/340.00+36.53);

Serial.print(" | gX = "); Serial.print(convert_int16_to_str(gyro_x));

Serial.print(" | gY = "); Serial.print(convert_int16_to_str(gyro_y));

Serial.print(" | gZ = "); Serial.print(convert_int16_to_str(gyro_z));

Serial.println();

// delay

delay(100);

}

'로봇 > 전기전자&메카' 카테고리의 다른 글

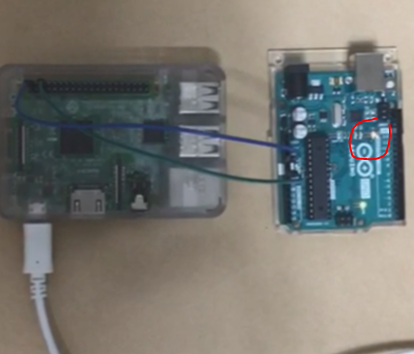

| 프로토타이핑 - 29. 아두이노와 라즈베리파이 양방향 통신 (0) | 2020.08.29 |

|---|---|

| 프로토타이핑 - 28. USB로 아두이노와 라즈베리파이 직렬 통신 (1) | 2020.08.29 |

| 프로토타이핑 - 26. 라즈베리 파이에서 아두이노 전원 주기 (0) | 2020.08.29 |

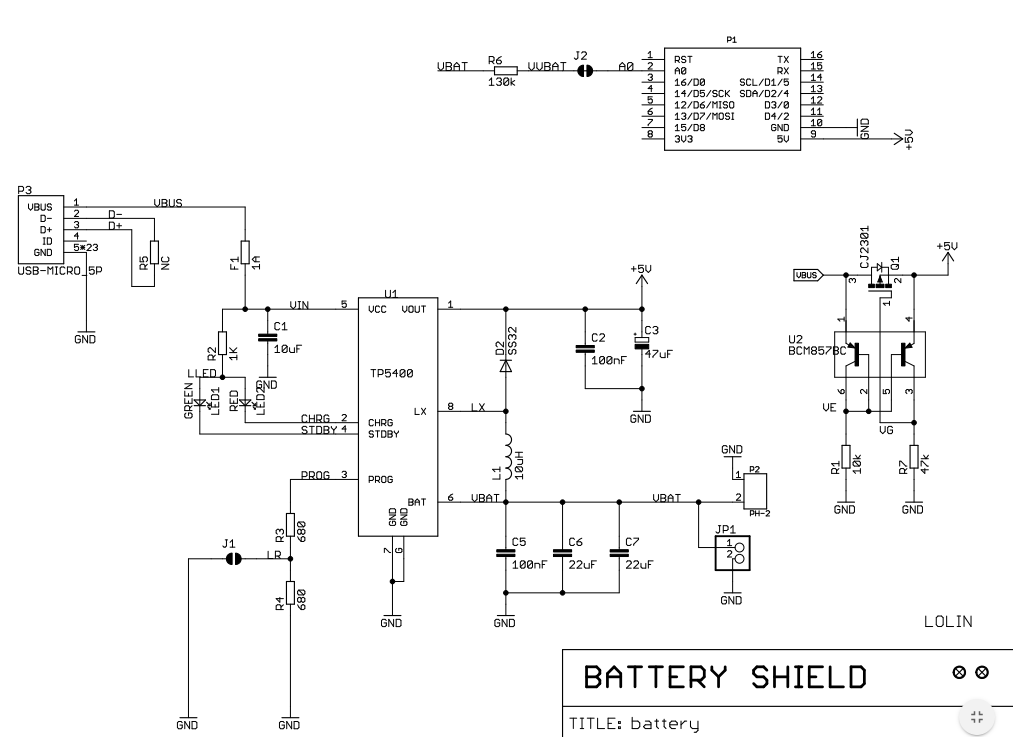

| 프로토타이핑 - 25. 베터리 고민 (0) | 2020.08.26 |

| 프로토타이핑 - 24. 파츠 (0) | 2020.08.25 |