'그외 > 로그' 카테고리의 다른 글

| English Shadowing 영어쉐도잉 영어 따라말하기;위베어베어스2, 3편 (0) | 2021.04.19 |

|---|---|

| English Shadowing 영어쉐도잉 영어 따라말하기;위베어베어스1편 (0) | 2021.04.17 |

| 인생 가장 최고의 순간으로 돌아가는 방법 (0) | 2021.04.11 |

| 2021.03.12 근황 (0) | 2021.03.12 |

| 2021.02.26 뭘 했더라 (0) | 2021.02.27 |

| English Shadowing 영어쉐도잉 영어 따라말하기;위베어베어스2, 3편 (0) | 2021.04.19 |

|---|---|

| English Shadowing 영어쉐도잉 영어 따라말하기;위베어베어스1편 (0) | 2021.04.17 |

| 인생 가장 최고의 순간으로 돌아가는 방법 (0) | 2021.04.11 |

| 2021.03.12 근황 (0) | 2021.03.12 |

| 2021.02.26 뭘 했더라 (0) | 2021.02.27 |

| English Shadowing 영어쉐도잉 영어 따라말하기;위베어베어스1편 (0) | 2021.04.17 |

|---|---|

| 키다리 아저씨 1 (세계 명작 소설 영어 원서 독해, 해석, 영어 리딩) daddy long legs 1 (0) | 2021.04.11 |

| 2021.03.12 근황 (0) | 2021.03.12 |

| 2021.02.26 뭘 했더라 (0) | 2021.02.27 |

| 리딩이 힘들어 (0) | 2021.02.23 |

최근 딥러닝 공부를 하면서 합성곱 신경망에 대한 전반적인 이론들을 살펴보았고, 최근 자연어 처리를 위한 순환 신경망에 대해서 정리해보고 있다. 하지만 합성곱 신경망의 경우에는 예전부터 조금씩 본적이 있었지만, 순환 신경망의 경우 합성곱 신경망 만큼 친숙한 개념이 아니어선지 생각보다 진도 나가기가 너무 힘들더라.

분명 지지난주 신경망 학습 방법들에 대해서 정리할때 까지만 해도 지금 보다는 의역이 잘 되는 편이었는데, 여기서 설명하는 로직이 잘 이해가 되지 않아서인가 의역이 제대로 되지도 않고 진행 속도가 크게 느려졌다. 그나마 다행인 점은 그동안 너무 하기 싫고 힘들었던 순환 신경망이 많이 늦어지기는 했지만 조금씩 조금씩 본 덕에 조금은 이해는 됬고, 정리하는 속도도 아주 약간은 빨라진것 같다.

하지만 이 부분에서 전에 진행하던 속도보나 너무 늦춰지다보니 시간을 너무 많이 지체해버리긴 했다. 다른 공부도 같이 병행을 하기는 해야하지만. 지금 딥러닝 이론에 나오는 내용들이 다양한 논문들에 나온 방법들을 정리한 것이기도 하고, 그렇다고 딥러닝 실습을 하자니 이런 내용을 이해하지 않고서는 왜 딥러닝 프레임워크로 신경망 모델링을 그런식으로 하는지 알수가 없으니 이 부분은 짚고 넘어갈수 밖에 없다고 생각한다.

한 강의만 가지고 몇일, 한두주씩 시간을 낭비해버리고 있으면서 차라리 다른 사람이 정리한걸 참고하면 되지 않나 생각도 들기는 하지만 괜한 고집 때문인지, 혼자서 이걸 해내고 싶어선지 남의 것을 보고 넘어가고 싶지는 않다. 분명 내것 보다 훨씬 정리 잘한 사람도 많기는 하지만, 내가 억지로 붙들고 이해하려고해서 살펴본것과 남이 이쁘게 정리한걸 보는것과 공부하는데서 느낌도 다르고..

과하게 시간을 낭비하는것 같긴한데, 아닐수도 있고 마음 먹기 나름인 문제이긴 하지만 너무 편한 환경에 놓은게 가장 큰 것 같다.

| 키다리 아저씨 1 (세계 명작 소설 영어 원서 독해, 해석, 영어 리딩) daddy long legs 1 (0) | 2021.04.11 |

|---|---|

| 인생 가장 최고의 순간으로 돌아가는 방법 (0) | 2021.04.11 |

| 2021.02.26 뭘 했더라 (0) | 2021.02.27 |

| 리딩이 힘들어 (0) | 2021.02.23 |

| 2021.02.19 이번주에 뭘했더라 (0) | 2021.02.19 |

이번 주에는 그래도 설 연휴 쉬고난 직후였던 지난 주보다는 마음 잡고 조금은 더 많이 할 수 있었다.

통계적 학습 기법

이번 주 동안에는 분류 문제를 다루는 다양한 통계적 학습 기법을 살펴봤는데 대표적으로 로지스틱 회귀 모델과 선형 판별 분석, 그리고 이차 판별분석 등을 살펴 봤었고, 다양한 시나리오 그러니까 데이터들이 어떤 특성을 보이는지 분포가 어떻게 되는지와 같은 상황에 따라 비모수적 분류 모델인 KNN 분류기를 포함하여 각 방법들이 어떤 특성과 성능을 보이는지 정리할 수 있었다.

이 외에는 뭐더라.. 그 리샘플링 방법에 대해서 간단히 살펴봤는데, 대표적인 리샘플링 방법인 교차 검증이나 부트스트랩 같은 방법에 앞서 가장 간단한 방법인 홀드 아웃에 대해서 살펴보면서 일단 통계적 학습 기법을 마무리하였다. 이번 주중으로 챕터 5장은 마무리 해야지

컴퓨터 비전을 위한 딥러닝

다음으로 컴퓨터 비전을 위한 딥러닝의 경우 이번주 초에는 상당히 고생을 했었다 1시간 짜리 영어 강의를 이해하기 위해서 번역을 하면서 정리를하는데 강의 하나를정리하는데 순수하게 8 ~ 12시간 쯤 걸리는것 같다. 왜냐면 직독 직해가 가능한 간단한 표현들도 존재하지만 특히 이론적인 동작 원리를 설명하는 부분에서 직독 직해가 안될 때가 많고, 이게 실제 강의한 내용들을 정리하다 보니 구어체적인 표현들이 내가 배웠던 영어 문법과 맞지 않아 교수님이 문법을 엉터리로 하구나?라고 생각이 들기도 했었다. 사실 내가 다양한 표현들을 제대로 공부안해서 모르는거기도 하지만

하지만 내가 이 강의를 정리할 때 가장 큰 문제는 표현들을 모르는것도 있지만 너무 직역을 하려고 하고 있었더라 적당히 의역을 해야하는데, 나도 모르는세 한단어 한단어 의미를 바꿔가면서 하려고하다보니 시간도 오래걸리고 말도 덜 자연스러웠다. 거기다가 내가 이해하지 못하는 부분이 생기면 따로 검색을 하거나 파파고 번역기도 돌려보고 어떻게 하면 이걸 정리할수 있을까 삽질하느라 시간이 너무 소모가되고 붙잡고할 맨탈도 너무 무너졌었다.

그런 이유로 어떻게 하면 리딩을 잘 할수 있을가 검색하다가보니 내 문제는 리딩 보다는 분명 아는 단어들인데 왜 해석을 해도 이해가 안되는 말들이 나오는지가 문제였고, 이에 대한 유튜브 검색을 하다가 내가 의역을 잘 하지 않는다는걸 알게되었다. 그 덕분에 이후에는 교수님이 문법에 맞지 않는 단어들을 사용한다 해도 거기에 큰 의미를 두지 않고 나름대로 의역을 하려고 신경 쓴 덕분에 이전 보다는 내용을 정리하는데 약간은 시간이 더 빨라진것 같았다.

그리고 이전까지는 PPT에다가 정리를 해왔었는데 이걸 정리하는데 낭비하는 시간이 너무 많아서 아예 블로그에다가 올리고 있고, 지난번에 다 못뽯었던 신경망을 잘 학습시키기 위해서 학습전에 설정해야 할것들, 활성화 함수, 데이터 전처리, 가중치 초기화, 규제 방법들에 대해서 전체적으로 살펴 볼수 있었다. 또 다음 강의에서는 신경망을 잘 학습하기위해서 알아야 할 것들 중에 가중치 감쇄에 관한 내용들을 살펴 보았다.

기타

이 외에는 알고리즘 공부를 하던중 이번에는 그래프에 대해서 정리해보았다. 이전부터 SLAM에 대해 관심을 가져오다보니 그래프에 대해서 제대로 공부를 하고 싶어했었는데, 오랜만에 그동안 공부했던 내용들을 한번에 다 정리해볼 수 있었다.

간단하게 그래프가 무엇인지 어떻게 생겼는지, 그리고 그래프를 어떻게 표기를 할수 있는지, 그래프에 대한 종류, 그래프를 저장하는 방법과 그래프의 사용 예시까지 우선 첫번째 글에서 다루었고

그 다음으로는 그래프 이론에 대한 배경 쾨니히스베르크의 다리 이야기에서 부터 시작하였다. 쾨니히스베르크의 다리, 해밀턴 경로, 외판원 문제 TSP에 대해서 살펴보면서 TSP가 NP-완전 문제였는데, 이전 부터 도대체 NP-완전이 뭔지 NP가 뭔지 감이 잘 잡히지를 않았었다

그렇다보니 이번에 이 개념들을 한번 정리해보자 해서 NP에 대한 글을 찾아봤고, NP가 비결정론적 튜링머신으로 다항식 시간에 풀수 있는 문제라는걸 알게 되어 그러면 튜링 머신이 뭔지 비결정론적인 튜링 머신이랑 뭐가 다른지를 그리고 다항시간이 뭔지 등을 나오는 개념들 중에서 내가 NP-완전이라는 단어를 한번에 정리할수 있을 만큼 모르는 개념들을 계속 파고파고 들어갔다.

그 덕분에 튜링 머신이 무엇인지, 추상 기계의 한 종류이며 사고 실험을 하는데 사용하는 것인걸 알 수 있었고, 비결정론적인 튜링머신이란게 튜링 머신이 한번의 상태에 대한 연산만 가능했다면 아무것도 안하거나 여러가지를 동시에 할수 있는 튜링머신이란걸 알수 있었고 실제로 구현을 할수가 없어 비결정론적인 튜링 머신으로 풀수 있는 문제들은 정확한 해를 구하지 못하고 근사적인 방법으로 푼다는 것을 알 수 있었다.

이 외에도 이러한 개념들이 계산 이론, 계산 복잡도 이론에 관한 것이다 보니 결국에 계산 복잡도 이론이 현실에 존재하는 수 많은 문제들을 다양한 복잡도를 기준으로 분류하기 위한 문제 집합에 대한 연구 분야라는걸 알 수 있었고 EXPSPACE, EXPTIME, PSPACE, PTIME, NP 등과 같은 용어들이 문제 집합이라는것을 알 수 있었다. 그래서 대략적인 NP완전에 대한 개념들을 이애 할 수 있었다.

마지막으로는 그래프를 이용한 탐색 방법이 어떤것들이 있는지 DFS, BFS가 있는지를 간단하게 보고, 백트래킹이 무엇인지 보고 제약 충족문제 CSP가 어떤것들이 있는지 살펴보면서 마무리할수 있었다.

| 인생 가장 최고의 순간으로 돌아가는 방법 (0) | 2021.04.11 |

|---|---|

| 2021.03.12 근황 (0) | 2021.03.12 |

| 리딩이 힘들어 (0) | 2021.02.23 |

| 2021.02.19 이번주에 뭘했더라 (0) | 2021.02.19 |

| 2021.02.05 이번주 정리 (0) | 2021.02.05 |

요즘 공부하면서 집중하기 힘든것도 있지만

가장 시간 많이 빼았고 힘들게 하는건 영어 해석부분이다.

간단한 일상 회화를 하는 유튜브 영상 같은거는 이제 그래도 알아듣거나 이해하기는 수월하지만

지금 보고 있는 통계적 데이터 분석에 대한 교재나

컴퓨터 비전에 관련된 내용들을 공부할 때 사용하는 영어는 너무 해석하고 이해하기가 힘들더라

분명 똑같은 영어이지만

사용하는 단어나 표현이 달라서인가 단어 하나하나를 이해하더라도 이게 무슨 소린가 뭔가 잘 정리가 되지않는다.

그런 문제 때문에 단순한 한 두문장 때문에 3~40분을 낭비하게 될때가 많아지더라

내가 이해하느데 어려움을 겪는 단어들 자체가 그렇게 어려운건 아니지만

그런 내용들을 그대로 해석을하면 너무 이상해지고

늬앙스를 판단해서 의역을 하고 싶어도 문법에도 잘 맞지 않고, 문법이 맞다 하더라도

내가 알고있는 의미와 다른 용도로 쓰는것 같다.

지금 이 글을 보면서 내가 어떻게 하면 영어 글을 더 잘 읽을수 있는가에 대한 유튜브 영상을 틀어놓고 있다.

내가 저 영상에 집중하면 저 사람이 무슨말을 하는지 이해가 되고,

강사가 아닌 사람들의 말도 강사들이 하는 말 만큼은 아니지만 어느정도 이해는 된다.

하지만 이상하게 전공 서적에 나오는 영어 내용들을 보면 제대로 정리가 되지 않아서 좀 힘들긴하다.

우연히 파비란 분이 운영하시는 블로그를 알게되면서

blog.pabii.co.kr/artificial-intelligence-the-end/

인공지능 분야 교육에 대한 문제들을 많이 공감을 하고있어

나름대로는 실제 필요한 내용들을 공부하려고는 계속 전공 원서들을 보려고 하지만 리딩 능력이 늘어나지 않고 정체되어 힘들다

계속 잘 이해가 되지 않는 원서 보기가 힘들고 꾸준히 하기가 힘들어지고있다.

이전에 대학원 다닐때 이런 문제때문에

대학원생 때 알았더라면 좋았던 것들

gradschoolstory.net/terry/readingpapers/

같은 블로그에서 많이 찾아보고 했지만

이런 논문 읽는 테크닉이 있더라도 정작 내용 늬앙스가 파악이 안되니 힘드네.

아니면 내가 너무 저스틴 존슨 교수님 강의같은 경우 말을 편하게 하는걸 억지로 해석하려고 해서 그런가 싶기도하고

잘 모르겟다.

잠깐 이걸 어떻게 해야되나 싶어 리딩 실력을 늘리는 법 같은걸 검색해봤는데

몇몇 유튜브 영상에서 리딩 스킬을 늘리는 법으로

단어 단위로 일찌말고 덩어리로 읽어야되,

중요하지않은 내용은 넘어가 라는 얘기를 하더라

그런데 나한태 도움되는 내용은 아니더라

그런 리딩 스킬은 알고 있고, 단어도 알고 있는데 자연스럽게 해석이 되지 않는게 문제니까!

그래서 이번에는 한번 어떻게하면 영어 늬앙스를 잘 이해할수 있는지 검색해보았다.

하지만 그래도 나한태 필요한 내용이 잘 보이지는 않더라

이번에는 우리나라 사람들이 많은 컨탠츠를 찾아봣느데

손꾸락 tutor라고 하는 유튜버 분이 내가 답답했던 부분에 대해서 설명을 해주더라

저스틴 존슨 교수님이 강의를 듣거나 자막을 볼떄마다

내가 알고 있는 문법대로 말하지를 않으니까

내가 늬앙스를 제대로 캐치 못하고 있다고 감안은하면서도

교수님은 문법을 엉망으로 말하구나, 말을 왜이렇게 하는건가, 말을 이상하게 한다라는 식으로 생각이 들고

정말 골머리를 많이 썩었다.

손꾸락님의 강의에서 맨 처음에 되게 잘 설명해주시던부분이 있었는데

i'll get back to you on that 이라는 문장에 대해 설명해줬다.

나는 매번 이런 문장을 볼때마다

단어 뜻을 그대로 나름대로는 의역하려 했으나 '나는 너한태 나중에 갈께'? 그런식으로 해석하고

on that 을 보고 아무 생각없이 보면 이사람이 문법을 몰라서 이렇게 했나 싶었지만

on that을 그거에 대해서로 보고

"그거에 대해서 나중에 연락할께"로 의역하더라

이후에 나오는 예시 중에 make up 이란 단어를 보는데 이걸 보충한다는 의미로 의역을 해서 사용하더라

make up class -> 보충 수업

make up with your boyfriend -> 남친과 보충해 -> 남친과 화해해

이 영상에서 나오는 예시 말고 takeaway라는 단어를 볼떄마다

takeaway 자꾸 가저가다 가져가다로 해석이 자동적으로 되지만

해야할일, 중요한일로 해석해야하는데 쉽지않다.

다음 예시는 ask for 요청하다

you asked for it이 너가 그걸 요구한거야 가 아니라

너가 자초한거야라는 식으로 의역했다.

그동안 저스틴 교수님 강의 볼때 나름대로는 음성도 듣고, 자막도 보고, 주위 상황도 보려고 했지만

의역이 잘하기 힘들어도 계속해야지 ..

| 2021.03.12 근황 (0) | 2021.03.12 |

|---|---|

| 2021.02.26 뭘 했더라 (0) | 2021.02.27 |

| 2021.02.19 이번주에 뭘했더라 (0) | 2021.02.19 |

| 2021.02.05 이번주 정리 (0) | 2021.02.05 |

| 2021.02.04 daily english study log (0) | 2021.02.05 |

지난주 설 연휴를 보내다가 이전에 공부하던 페이스를 잃어버렸다.

전에는 거의 매일 영어 로그도 쓰고, 막 뭔가 열심히 했던거 같은데 다시 전처럼 하기가 쉽지 않다.

오는 주에는 이전 페이스를 되찾으려고 좀 노력해야할거 같다.

이전에 내가 생각하던 목표는 매주 논문도 읽고, 영어 공부도 하고, 통계/딥러닝도 같이 공부하려고는 했지만 딥러닝 정리할떄 까지만 했어도 할만 했지만 통계 정리가 추가되는 순간부터 쉴시간이 전혀 없어지니 계획대로 하기가 너무 힘들더라

그래서 글을 남기지는 못했는데 어짜피 딥러닝, 통계 이론들이 다 논문에서 나온거니 굳이 논문을 읽을 필요가 있나? 싶더라. 지난 주말에 내가 정리한 신경망 아키텍처에 관한 강의에만 해도 제대로 본 신경망 아키텍처만 AlexNet, ZFNet, VGG, GoogLeNet, ResNet 5개 정도를 봤고, 그 외에도 간단하게나마 ResNext, SENet, MobileNet, Network Architecture Search 까지 볼수 있었으니 이 강의에 논문 여러개가 정리 되어 있으니 말이다. 추가 논문 보는건 이 강의 모든 내용을 정리하고 여유가 생길때 보는게 좋을것 같다.

추가로 딥러닝에 관해 매주 문제를 몇 개씩 만들고 있었는데, 이런 문제를 만들면서 내가 이전에 몰랐던 내용들을 한번 더 다시 정리하면서 많이 도움이 되는걸 느끼고 있다. 특히 이번주에 5문제를 만들면서 sigmoid와 tanh를쓰다가 왜 relu를 사용하게 되었는지 그리고 reaky relu인가 이 함수를 왜쓰게 되었는지 이해한 점이나 드랍 아웃과 internal covariate shift에 대한 개념을 다시 살펴보면서 조금더 명확히 이해되어 많이 도움되었다.

영어 공부도 도저히 할 여력이 없어서 별도로 시간 내서 하는 대신 밖에 나갈 때 마다 BBC 라디오를 들으며 돌아다니고 있다. 확실히 라디오가 듣기 좋은게 유튜브에서 올라오는 공부 영상은 듣기 너무 쉽거나, 듣기 너무 힘든게 많더라 특히 드라마가 문화적인 표현도 많고 발음도 듣기 힘들었다. 하지만 라디오 같은 경우에는 다양한 인종 사람들이 나오고 이런걸 고려해선지 발음이 훨씬 듣기는 수월하더라.

그래서 꾸준히 BBC 라디오를 듣고 있는데 처음 들었을때 말의 6~70%가 그냥 흘러가거나 잘 안들렸다면 지금은 3~40% 정도로 줄어들어 이해를 하고 안하고를 떠나서 편하게 들리는 정도가, 청취력이 많이 늘어난것 같아 다행이다. 만약 계속 유튜브에 어려운 영어 공부 드라마 같은거를 틀어 놓고 보려 했으면, 쉽게 쉽게 하다가 가끔식 어려운걸 해야지 라디오에서 거의 사용하지도 않는 어려운 표현들을 연달아서 들었으면 진작에 포기해버렸을거같다.

오는 주에는 전 페이스를 찾아서 다시 열심히 하자

| 2021.02.26 뭘 했더라 (0) | 2021.02.27 |

|---|---|

| 리딩이 힘들어 (0) | 2021.02.23 |

| 2021.02.05 이번주 정리 (0) | 2021.02.05 |

| 2021.02.04 daily english study log (0) | 2021.02.05 |

| 2021.02.01 daily english study log (0) | 2021.02.02 |

이번 주에는 전보다 제대로 공부하지 못한것 같다. 통계 스터디를 참여하게 되었는데 목요일날 처음 참여하고, 이번주 부터는 월요일에 하다보니 주말에 다른걸 못하고 통계 정리를 급하게 먼저 하는 바람에, 딥러닝도 절반 조금 안되는 내용을 정리하기는 했다만은 지난주 보다 시간을 써야 하게 되었다.

지난주 목요일에는 통계적 학습 기법이 어떤것들이 있었는지 봤다면 이번 주 월요일에는 선형 회귀 모델에 대해 보다보니 단순 선형 회귀, 다중 선형 회귀, 분산과 편향 트레이드오프, 변수 선택, MSE, 선형 회귀 평가를 위한 RSE나 R2같은 것들을 보았다. 그래서 이걸 하느라 토요일 대부분 시간을 쓰고

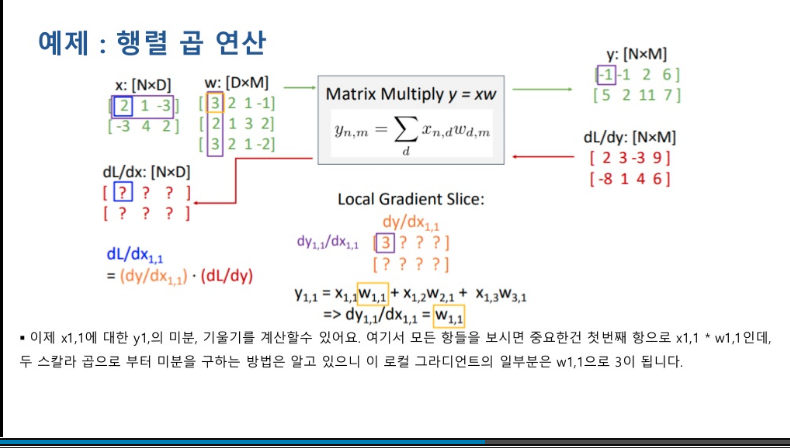

일요일에는 딥러닝에 대해서 정리하는데, 이번에는 주제가 역전파였다. 그동안 선형 분류기가 어떤 관점들로 볼수 있고, 최적화 기법이 어떤게 있고, 신경망이 어떻게 구성되는지 등을 보았고 이 신경망의 전체 파라미터를 학습시키는 벙법인 역전파에 대해서 보았는데, 계산 그래프 부터 스칼라 값에 따른 그라디언트, 벡터에 따른 그라디언트, 텐서에 대한 그라디언트, 그리고 순방향 미분 자동 계산과 역방향 미분 자동 계산 등 내용들이 너무 많더라 그래서 월요일에는 절반 조금 안되게 정리를 하였고 나머지 내용을 하는데 수요일 까지 해버리고 말았다. 계속 밀려지니 하기 싫어지더라

원래는 딥러닝 내용만 정리해도 주말을 다 써버리는데 통계까지 해버리니 정말 쉴 시간이 없었다 그렇다고 통계 내용이 머신러닝 모델 설계가 어떻게 되는지, 변수들이 어떻게 출력에 영향을 주는지, 모델 설계하는지등을 파악하면서 이게 너무 유익하다보니 안할수도 없고, 그래서 원래는 리트 코드에서 프로그래밍 공부도 하기는 했지만 이제는 자료 구조 내용위주로 하고, 넌센스 문제는 시간 낭비인것 같아 가능한 안하려고 한다.

이런 일로 영어 공부도 제대로 못하고 있었다. 그런데 요즘 영어 쓰기는 문법 어휘가 엉터리더라도 쓰는게 많이 편안해졌고, 프렌즈처럼 너무 미국적인 내용들을 보면 잘 알아듣지 못할때가 많으나 밖에 나갈때마다 BBC 뉴스를 틀어놓고 돌아다닌다. 그런데 이걸 계속 듣고 있어선지 그동안 놓치던 단어들이 조금씩 들리기 시작하게 되더라. 특히 수요일날 외출하면서 오랜 시간 뉴스 라디오를 들으면서 직독 직해까지는 아니더라도 러시아 시위가 어떻게 되어가는지 신장에서 어떤일이 일어나는지 같은 내용이 나오는데 그게 조금식 이해하기가 시작했다.

또한 정신없이 금요일이 되어버렸고 여전히 많이 햇갈리지만 영어 정리 하는 과정이 전보다는 조금 자연스러워 지고, 이해 안가던 표현들이 이해가기 시작한것 같아서 조금 위안이 된다.

어제는 캐글 집값 예측 대회에 참여하면서 삽질을 좀 많이 했는데, 책에서 보여주는 스태킹 기법을 사용하려고 했지만 삽질하는 과정에 중간에 있는 코드들이 스파게티가 되어선지 맨 마지막에 넣은 스태킹 모델이 정상적으로 동작하는것 같지 않더라, 기본 모델도 뭔가 이상했다.

그래서 원래 쓰던 엉망이 된 코드를 버리고, 다시 처음부터 시작해서 디폴트 회귀모델이 집값을 잘 예측하는걸 확인하고, 파라미터 튜닝 과정을 거쳤다. 파라미터 튜닝 과정을 통해서 분명 성능이 향상도 시키고, 베이스라인 모델에서 사용하는 전체 모델의 평균 회귀 값을 이용하는 평균 모델을 만들어 사용했으나 베이스라인의 모델과 거의 비슷한, 크게 성능이 향상되지 않은 모델이 만들어 지고 말았다.

전부터 이해가 안가던게 데이터 분포가 치우쳐진 경우 왜도가 있는 경우, 로그 변환을하면 정규 분포에 가까운 형태로 바꾸면 성능이 개선된다고 한다. 그런데 실제로 로그 변환을 수행후 앙상블 모델에 적용시키면 오히려 오차가 증가해 버리더라. 내가 이해한건 데이터의 분포가 정규 분포가 따라야 성능이 개선되는것은 그 추정 모델의 오차가 정규성을 가지는 경우, 선형 회귀 모델갖이 회귀선을 중심으로 데이터가 일정하게 분포한 경우 성능이 개선되는것이지, 그런 방식이 아니라 결정 규칙을 만들어 나누어 가는 트리 기반 방법들에는 성능 개선이 안되는 것으로 알고 있다.

내가 잘못이해하고 있는건지 잘 모르겟다. 아무튼 오늘부터 주말까지 통계, 딥러닝도 잘 정리하고, 정말 논문 리뷰 할 시간이 남았으면 좋겠다ㅠㅜ

| 리딩이 힘들어 (0) | 2021.02.23 |

|---|---|

| 2021.02.19 이번주에 뭘했더라 (0) | 2021.02.19 |

| 2021.02.04 daily english study log (0) | 2021.02.05 |

| 2021.02.01 daily english study log (0) | 2021.02.02 |

| 2021.01.29 이번주 정리 (0) | 2021.01.29 |

unfortunately, yesterday, i was too tired to write anything and just fall in a sleep at a night. becaus i went to the hospital and the other place because of meeting reservation. altough i did hang around a long time, you know i did work out well, got exhauseted too much. nevertheless, i did tried to watch any video and seaching anything. i found one, altough i didn't want to watch learning english with blabla, there was shipsons! i was about to watch that, but fall in a sleep.

so, i could wake up ealry in this morning. then i tried to do my homework behinds me. i finished one as soon as possible, there are many things i didn't. plus, i have to participated in kaggle competition and i need to minimize rmse root mean squared error of the dataset, i tried all of thing i know but i'm not professional in kaggle, and my technique and comprehension about it was poor. that't really frustrating me despite of my hardship. i know i just see it and typing. then that looks like working well, and i passed it. but i did several times it but my comprehension is not better as much as i wish.

i coun't be depressed, should stand it. i spend all of times to do ti, after submit my prediction result, there are some lower bound i have to minimized my prediction rmse less than. that was big problem for me. i made a default estimators like random forest, gradient boosting, xgb, and made some stacking models. but my stacking models doesn't seems like working, and output was something wrong. so, i abandon it. instead, i try to used average model in base line. fortunately, the average model are working well. and i tuned hyper parameters of the models, and mixed up that models, my models become imporved.

neverthese, my average model's rmse did not reach to the bound but it could be very closer at that. anyway, today i was about to practice some writing using a english book that i borrowd, but i don't have any more time for that. so i wish i can write my dialog tomorrow too.

| 2021.02.19 이번주에 뭘했더라 (0) | 2021.02.19 |

|---|---|

| 2021.02.05 이번주 정리 (0) | 2021.02.05 |

| 2021.02.01 daily english study log (0) | 2021.02.02 |

| 2021.01.29 이번주 정리 (0) | 2021.01.29 |

| 2021.01.28 daily english study log (0) | 2021.01.28 |

these days, i didn't write down any english dialog. after last friday, i was hurried to translate about the book, statistical learning method. becuase i had appointment for a study group, i should be prepared to participate hardly.

after i almost finished that, i feel suddenly depressed on the saturday. i think it was because the last week i did best my self, but at that time i loose my study paces. there were still many things i have to do, i had to read some scholar paper, and prepare for computer vision presentation, and attend to the statistic study group. these made me frustrate.

so, i couldn't anything study or writing english harder than before. today also, my condition was not good enough but, from 11 pm or 12 pm, these usleness thoughs are gone, i could focus on what i do in present. i don't understand this mental phenomenon is wheter the reason is thanks to the medicne that i took, or my study pace goes well or i could concentrate on some coding examples.

and then, i was too much postponed my writing practice. i must n't delay off this any more. but nowadays i thought about my training method. because learning english with friend is very good source to study. they gave me many defailed expressions that i can use in practical situdations. nevertheless, that point seems to be a problem for me. because i have trouble with listening english. but the most of speaking i coun't understand is not expressions about english culture, but i think it is a sentences the native speakers usually speaks.

in my opinion, i should practice to listen common expressions more then cultural ones. this is my conclusion that i got this by listening bbc world radio everyday, i could understand some of words, but i couln't understand what i don't know the pronunciation. wait a minite! that's it. the problem is pronuncination i nerver tried to listen.

today i watched the video, to practice my listening skill and i choosed the another one instead of frieds because of the reason i already write. the video clip was not hard for me. most of speaker's saying was not hard to understand and pronunciation was easy as much as i could follow them. but it's a little slow.

anyway, the reason i got a problems with english, i never tried to study several pronunciation, just only focus on anything. and then frustrated and forgive it to study. by listening bbc radio, there were serveral pronunications of people i could understand or not. that gaves me intuition about listening i have to do linsten serveral it not only one cultures. and i should not have to dig deeper too much for preventing frustration.

theres are what i feld today. i hope today's experiences helps me.

| 2021.02.05 이번주 정리 (0) | 2021.02.05 |

|---|---|

| 2021.02.04 daily english study log (0) | 2021.02.05 |

| 2021.01.29 이번주 정리 (0) | 2021.01.29 |

| 2021.01.28 daily english study log (0) | 2021.01.28 |

| 2021.01.27 daily english study log (0) | 2021.01.27 |

1월 달의 마지막 주 정리를 해보자

이번 주 동안 논문 리뷰도하고, 컴퓨터 비전 강의 정리하고, 통계 학습 이론 1강 정리하고, 프로그래머스 시험도 치고, 연결리스트 알고리즘 문제 풀고, 영어 시험도 봤다. 이렇게 보니 뭔가 참 한게 많아 보이네.

우선 지난주 토요일부터 생각해보자 그때 프로그래머스 레벨 2 시험을 봤는데, 2번 정도는 실패하고 3번째 시도에서 통과하기 직전까지 갔었지만 시간 부족으로 한 문제를 통과하지 못하고 말았다. 사실 문제를 풀긴 했는데, 속도 때문에 통과 못한거긴 하지만 이따가 한번 풀어봐야지

이 시험을 보고 나서 논문 리뷰를 했는데, 그 뭐냐.. 초기 딥러닝 모델인 레쿤의 LeNet에 대해서 봤었다. 이 논문에서 완전 연결의 개념과 컨볼루션을 통해 특징들을 추출해내는 내용들이 나왔었던것 같다 잠깐 다시 봤는데 신경망을 구성하는 레이어를 커널로 서브 샘플링하고 컨볼루션 연산하는 이런 내용들이 나왔엇네, 하지만 이 논문에서는 LeNet의 구조에 대해서는 설명하지만 가중치가 어떻게 학습되는지에 대한 내용은 없었다. 일단 오늘이나 내일 시간 날때 역전파에 대한 논문 리뷰를 한번 해야되겟다.

일요일에는 거의 대부분 시간을 저스틴 존슨 교수님의 신경망 강의를 정리하는데 시간을 보냈다. 맨 처음 그동안 공부한 내용들을 배웠는데, 이미지 분류 문제를 풀기위해 선형 분류기를 대수적, 시각적, 기하학적 관점으로 보았었고, 선형 분류기로 입력과 가중치의 선형 결합을 이용하여 출력을 구하였고 이를 비용함수로 어디에 속하는지 찾아냈던것 같았다.

지난 시간 최적화를 공부하면서 가중치를 어떻게 학습하는지 배웟었다 랜덤 탐색 방법에서 시작하여, 경사 하강법에 대해서 배워가는데, 경사 하강법의 단점, 그리고 이를 보완한 SGD, SGD의 노이즈 취약과 지그제그로 수렴하는 문재를 개선하기 위해 모멘텀 개념을 사용했고, 관성에 더 가중을 준 네스트로프 관성이 있었다. SGD에서 모멘텀이 아닌 학습률을 조절하는 방향으로 나온 알고리즘이 Adagrad가 있었고, 이를 개선한게 RMSprop, RMSProp와 모멘텀을 합친 adam 최적화기에 배웟던걸로 정리할 수 있겠다.

이번 신경망 강의에서는 선형 분류기의 단점을 보고, 왜 신경망 모델이 효과적인지 배워보는 시간을 가졌다. 처음에 선형 분류기의 단점과 선형 분리 불가 문제를 풀기 위해 특징 변환의 개념도 보고, 컴퓨터 비전에서 사용하는 특징들이 어떤것들이 있는지 보았다. 대표적으로 이미지 히스토그램, 그라디언트 방향 히스토그램, 단어 사전 등이 있었으며 이를 혼합한 특징이 2000년대 중반까지 많이 사용되고 있엇다고한다.

그러다 2011년 알렉스넷이 등작하면서 딥러닝 기반 방법들이 많이 뜨기 시작했는데, 다양한 특징들을 추출하고, 학습을해서 분류 문제를 해결할수 있었다고 한다. 선형 분류기와 딥러닝 모델의 차이를 보자면 선형 분류기를 이용한 분류의 경우 특징 추출 파트가 나누어져 있어 이 특징 추출 시 소수의 일부 파라미터들만 조절해서 학습시켰다고 한다면, 딥러닝 모델은 학습 모델 전체의 파라미터, 가중치들을 조절시킨다고 이애할수 있었따.

그리고 신경망 구조가 어떻게 되는지, 신경망이 다중 탬플릿을 어떻게 처리하는지, 활성화 함수가 하는일, 뉴런과 비교, 공간 변환을 통한 선형 분리, 규제 강도에 따른 일반화 성능 등을 보는것 까지 정리했었다.

화요일 날의 경우는 알고리즘 공부를 하면서 연결 리스트에 관한 리트 코드 문제들을 풀었다. 처음에 연결 리스트를 오랜만에 보다보니 손에 익지 않아 시간이 좀 걸렸었는데, 나머지 문제들은 첫 문제에 비해 빠르게 할 수 있었다.

수요일에는 내가 뭘했나 생각해보면 통계 자료를 정리했었다. 선형 모델이든 신경망 모델이든 다 통계 기반 학습 모델인데, 이전에 방통대 수업을 들으면서 전반적으로 공부는 했으나 뭔가 시원하게 정리 되지는 않았었다. 그런 이유로 공부의 필요성을 느끼고 있었는데, 다른 분이 이해하기 쉬운 좋은 책을 추천한게 있어서 이걸 번역하면서 좀 공부했다.

이날 본 내용들은 통계적 학습 모델이 무엇인지, 실제 결과가 나오는 법칙 참 함수 true function인 f에 가까운 함수, 추정 함수 f_hat을 구하는 문제이며 이 f를 추정해서 무엇을 할수 있는지 예측과 추론의 관점에서 보았다. 이후 모델 추정 방법에 대해 정리하면서 모수적 방법, 비모수적 방법의 개념을 전부터 알고있었지만 이번에 조금더 명확하게 이해가 되었다. 전에는 모수적 방법을 매개변수를 사용하는 방법이라 생각했는데, 모수적 방법은 그게 아니라 우리가 알지 못하는 문제 f를 특정한 함수 형태, 선형 모델이든, 비선형 모델이든 f_hat일 것이라고 정의하고 접근하는 방법이란걸 말이다.

비모수적 방법은 이와 다르게 함수적 형태를 가정하지 않고 추정 모델을 구하는 방법인데 함수적 형태가 없는데 어떻게 추정 모델을 구한다는 것인가 아직 감은 잘 안잡힌다. 이전에 비모수적 방법으로 k means, 히스토그램, 커널 밀도 추정이 있다는건 봣엇지만, 데이터에 의존하는 방법이기도 하다는건 알겠지만 뒷 부분들을 좀 봐야 될것같다.

수요일에는 여기까지 밖에 못하고, 나머지는 목요일까지 봤는데, 그 외에는 모델 복잡도와 정확도 사이 트레이드 오프 길항 관계, 비지도 학습과 지도 학습이 무엇인지, 회귀 문제와 분류 문제가 무엇인지, 모델 정확도 평가, 편향과 분산(모델 복잡정도?)에 따른 MSE 길항 관계, 분류 문제가 무엇인지 가장 기본적인 베이즈 분류기. 베이즈 분류기는 여러번 봤지만 여전히 햇갈리는게 아까 봣던 실제 모델을 조건부 확률로 표현한걸 베이즈 분류기라고 하는것 같긴 하다. 그거 말고는 자주봤던 최근접 이웃 분류기까지 하고 마쳤다.

목요일에는 통계 자료 본것도 있지만 어제 영어 시험을 봤고, 시험 자체는 망친것 같았는데 생각보다 성적은 잘 받은은것 같더라 IM2, Speaking 6 ! 실제 스피킹을 보면 이만큼 되는것 같지는 않지만..

아무튼 내가 지난 한주 동안 이렇게 보냈고, 이제 뭐해야하나 통계 3강 보고, 딥러닝 6강 보고, 프로그래머스 시험도 쳐보고, 그래도 개념이 정리되는것 같아서 좋긴하다.

아 .. 오늘 비지도 학습에 대해서 공부했는데 그 중에 PCA를 보면서 이전에 공부했던 내용들이지만 잘 생각이 안들더라 선형 대수 이론에 대해서 한번 복습해야지 계속 생각은 했었는데, 그래서 잠깐 찾다보니 다크프로그래머님이 잘 정리해놓으신게 있어서 이걸 보면서 좀 정리해야할것 같다. 밑바닥부터 딥러닝은 글 쓴지 한참 됬는데 아직 까지도 정리 못하고 있는데 언젠간 할수있겟지 모르겟다.

| 2021.02.04 daily english study log (0) | 2021.02.05 |

|---|---|

| 2021.02.01 daily english study log (0) | 2021.02.02 |

| 2021.01.28 daily english study log (0) | 2021.01.28 |

| 2021.01.27 daily english study log (0) | 2021.01.27 |

| 2021.01.26daily english study log (0) | 2021.01.26 |