728x90

Getting Matrix Dimensions Right (C1W4L03)

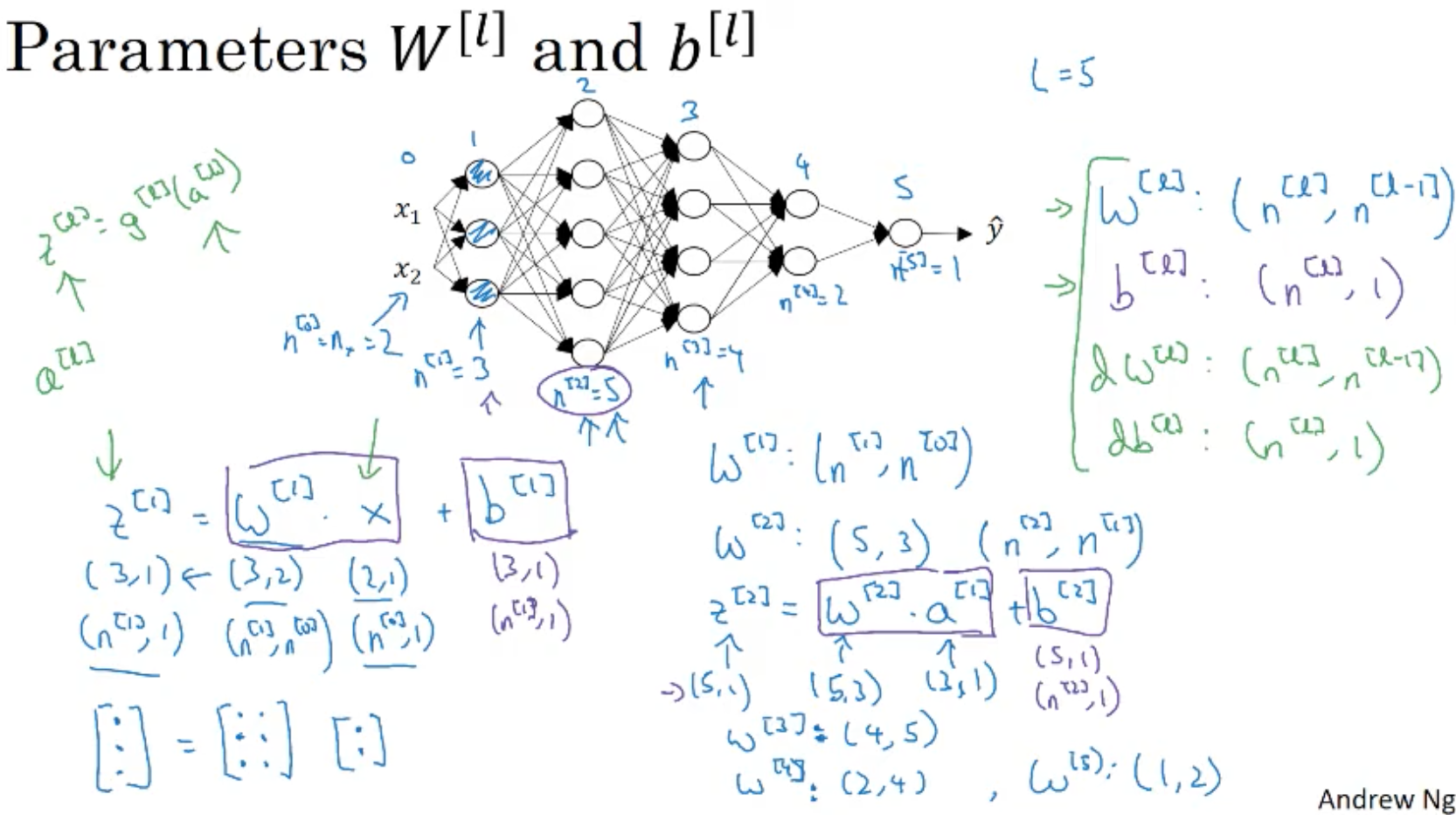

파라미터 w와 b

- 심층 신경망 구현시 행렬 차원을 잘 확인 해야 한다. 직접 적어가면서 확인해 보자

- L = 5

- z^1 = w^1 x + b^1

- n^[0] = 2, n^[1] = 3, n^[2] = 5, n^[3] = 4, n^[4] = 2, n^[5] = 1

- z^1's shape = (3, 1) = (n^[1], 1)

- x's shape = (2, 1) = (n^[0], 1)

=> w^1's shape = (3, 2) = (n^[1], n^[0])

=> w^l's shape = (n^[l], n^[l-1])

- w^3's shape = (4, 5) = (n^[3], n^[2])

- bias

b^[1]'s shape = (3, 1) = z^[1]

b^[l]'s shape = z^[l]

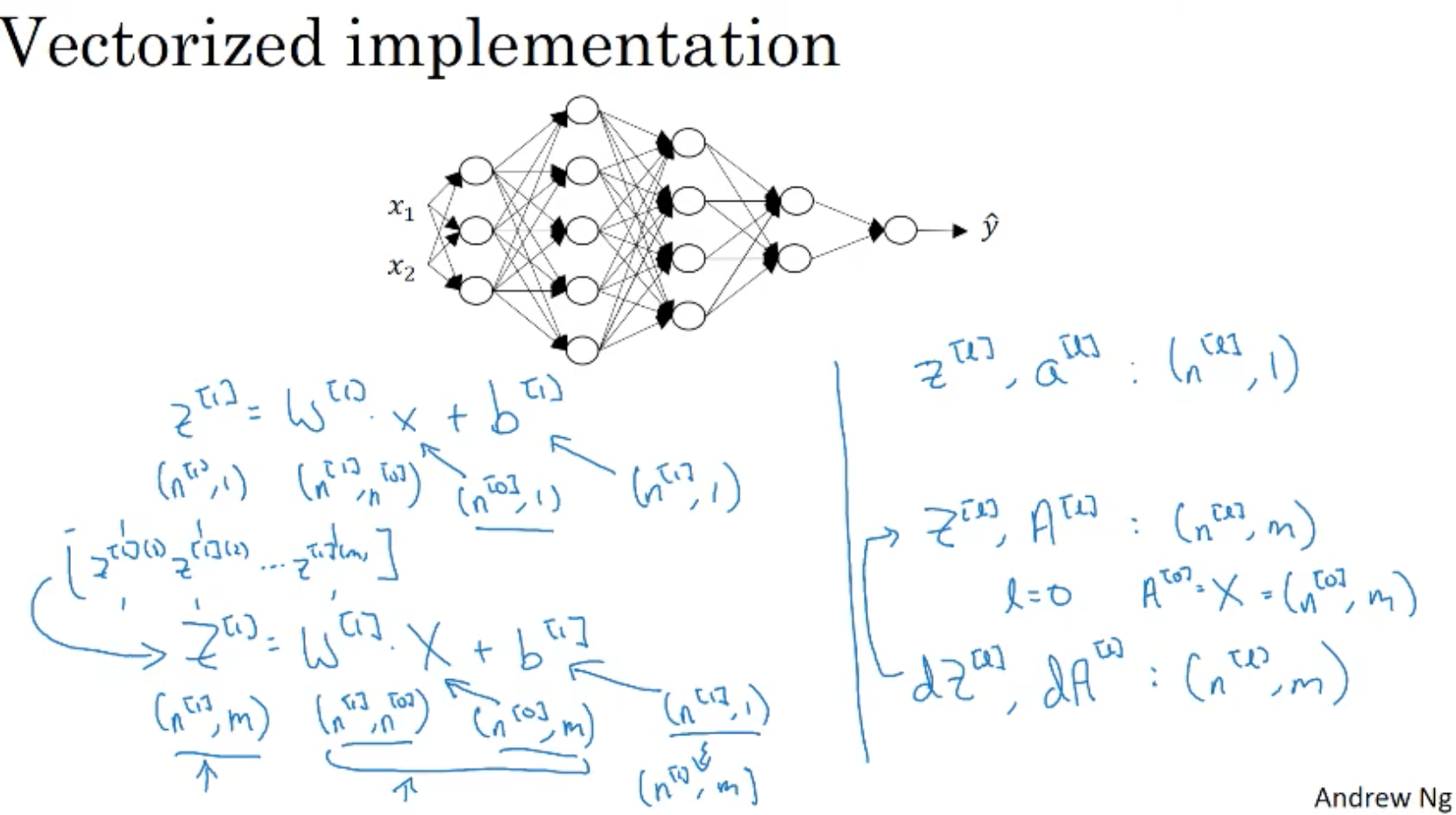

벡터화 구현

- w, dw, b, db의 차원은 동일하나 x와 z, a는 변함.

- 단일 샘플에서 z^[l], a^[l] : (n^[l], 1)

- 전체 셋에선 Z^[l], A[l] : (n^[l], m)

- 입력 X = (n^[0], m)

- 심층 신경망 구현시 차원 부분을 놓치다가 버그 발생할 수 있으니 조심하자.

300x250

'컴퓨터과학 > 딥러닝 AI Andrew Ng' 카테고리의 다른 글

| C1W4L05 Building Blocks of a Deep Neural Network (0) | 2021.04.29 |

|---|---|

| C1W4L04 Why Deep Representations? (0) | 2021.04.29 |

| C1W4L02 Forward Propagation in a Deep Network (0) | 2021.04.29 |

| C1W4L01 Deep L-Layer Neural Network (0) | 2021.04.29 |

| C1W3L09 Gradient Descent For Neural Networks (0) | 2021.04.29 |