728x90

Logistic Regression Gradient Descent (C1W2L09)

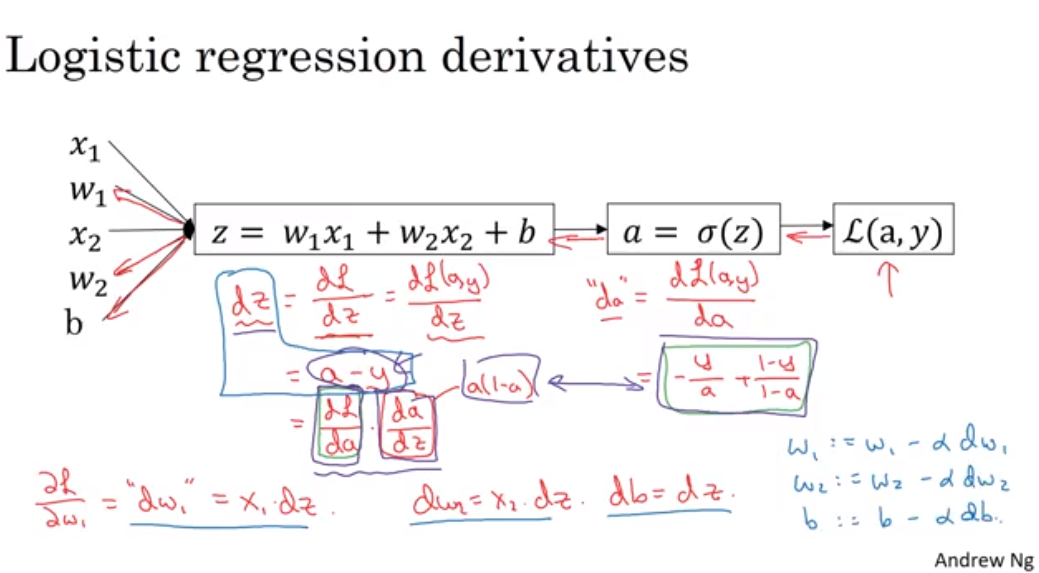

로지스틱 회귀 복습

- 로지스틱 회귀에 사용할 계산 그래프로 경사 하강 구현하기

- 비용함수 L(a, y)를 줄이도록 파라미터들을 학습하자.

로지스틱회귀 미분계수 구하기

- 다운스트림 그라디언트 = 로컬그라디언트 * 업스트림 그라디언트 (체인룰)

- w1 := w1 - alpha * dw1

- w2 := w2 - alpha * dw2

- w3 := w3 - alpha * dw3

Gradient Descent on m Examples (C1W2L10)

m개의 데이터를 이용한 로지스틱 회귀

- 지난시간에는 1개의 샘플에 대했다면 이번에는 m개의 샘플을 다뤄보자.

- m개의 데이터에 대한 dw1의 평균을 구하면 dw1를 구할 수 있다.

- 아래의 슬라이드는 경사하강의 한단계 수행한 것이며, 여러 단계를 거쳐 최적점에 도달해야함.

- 신경망 알고리즘 구현시 명시적으로 루프 문을 돌리면 효율성이 떨어짐.

- 루프를 명시적으로 해서 각 데이터를 처리하는 것이 아니라 백터화를 통해 묵시적으로 큰 데이터를 처리하는것이 중요함.

300x250