4.3.4 다중 로지스틱 회귀 Multiple Logistic Regression

이번에는 입력 변수가 여러개인 경우 이진 분류하는 문제를 생각해봅시다. 3장에서 본 다중 선형회귀에서 확장시켰던것처럼 식 (4.4)를 아래와 같이 일반화 시켜 나타낼수 있을 거에요.

여기서 X = ($X_{1}$, . . ., $X_{p}$)로 p는 입력 변수의 개수가 되겠죠. 그러면 이 식 4.6은 아래와 같이 정리 할수 있을거에요.

4.3.2장에서 본것 처럼 최대 가능도법을 사용해서 계수 $\beta_{0}$, . . ., $\beta_{p}$들을 추정하면 되겠습니다.

표 4.3은 카드 대금 balance와 수입 income, 학생 여부를 이용해서 채무 불이행 여부, 디폴트 여부의 확률을 예측하는 로지스틱 회귀 모델의 계수를 추정한 결과를 보여주고 있어요. 결과를 보면 카드 대금과 학생인 경우의 가변수에 대한 p value가 매우 낮으므로 이 변수들이 디폴트 확률과 연관되어 있는걸 알 수 있습니다. 하지만 학생인 경우의 계수 추정치가 - 0.6468로 음수이므로 학생이 아닌 경우보다 디폴트가 될 확률이 덜하다는 얘기가 됩니다.

이건 표 4.2에서 가변수가 양수가 나온것과는 좀 다른데, 어떻게 표 4.2에서 디폴트 확률이 증가하도록 하던게 표 4.3에서는 디폴트 확률을 줄이도록 하게 만들었을까요?

그림 4.3의 왼쪽 판낼은 이 역설적인 상황을 그래프로 보여주고 있는데, 오랜지 색과 파란색 직선은 카드 대금이 주어질때 각각 학생과 학생이 아닌 경우의 평균적인 디폴트 비율을 보여주고 있어요.

이 다중 로지스틱 회귀 모델에서 학생에 대한 계수가 음수라는 것은 (잔금과 수입이 변하지 않았을때) 학생이 아닌 경우보다 디폴트가 될 가능성이 낮다는걸 의미 합니다.

하지만 이 플롯의 바닥 근처에 있는 평행 점선은 카드 대금과 수입 전체에서 학생과 학생이 아닌 경우의 평균적인 디폴트 비율을 보여주고 있는데, 직선과는 다르게 전체 학생의 디폴트 비율이 비학생의 디폴트 비율보다 높죠.

그래서 표 4.2의 단순 로지스틱 회귀 모델에서 학생에 대한 계수가 양수값이 되요.

그림 4.3의 오른쪽 판낼은 이 불일치한 상황에 대해 참고가 되는데, 여기서 학생과 카드 대금이 상관관계를 가지는걸 볼 수 있어요. 학생은 빚이 전반적으로 많아 디폴트가 될 확률이 더 높을거에요. 다시 말하면 학생들은 카드 대금이 클 가능성이 많아 그림 4.3의 높은 디폴트 비율이 나오게 되요.

그래서 카드 대금이 같을때 학생 개인으로 보면 비학생보다 디폴트가 될 확률이 낮지만, 학생 전체적으로 카드 대금이 많다보니 비학생보다 디폴트 비율이 높게 나오게되요.

이는 신용카드 회사에서 신용을 제공할지 여부를 판단하는데 중요한 일이라고 할수 있을 겁니다. 한 학생의 신용 카드 대금에 대한 정보가 없다면 비학생보다 학생이 더 위험할 거에요.(학생은 기본적으로 빚이 많으니) 하지만 학생과 비학생의 가드 대금이 같은 경우라면 학생이 덜 위험할 겁니다. (빚이 적은 학생이다.)

정리

- 학생 여부에 따른 디폴트 여부만 본다면 (학생이 기본적으로 빚이 많으므로) 학생이 디폴트가 될 학률이 크다.

- 학생 여부와 카드 대금을 고려 한다면 비학생보다 디폴트가 될 확률이 낮다.

이 간단한 예제를 통해서 다른 입력 변수들 끼리 연관 되어 있을때 입력 변수를 하나만 써서 회귀 모델을 사용하는 경우 생기는 위험들을 알아볼 수 있었습니다. 선형 회귀의 경우 하나의 입력 변수 만으로 얻은 결과는 (특히 입력 변수들 끼리 상관관계가 있을때) 여러개의 입력 변수를 사용한 경우와 상당히 달랐었죠. 그림 4.3에서 보았던 이런 현상을 confounding라고 하며 여기서는 혼재라고 적겟습니다.

표 4.3의 회귀 계계수 추정치를 식 (4.7)에 넣어 예측을 할수 있게 되었습니다. 만약 카드 대금이 $1,500이고, 수입이 $40,000인 학생의 경우 디폴트가 될 확률은 아래와 같을 거에요.

하지만 같은 카드 대금과 수입을 가지고 있는 비학생의 경우 디폴트가 될 확률을 추정하면 아래와 같이 구할수가 있겠습니다.

4.3.5 클래스가 2개 이상일떄 로지스틱 회귀 Logistic Regression for > 2 response classes

우리가 2개 이상의 경우를 분류해야하는 상황도 있을 겁니다. 예를들어 4.2장에서 봤던 응급실에서 질병 medical condition에 대해 3 카테고리가 있었죠. 뇌졸증 stroke, 약물 과다 복용 drug overdose, 간질 발작 epileptic seizure. 이 경우 Pr(Y = stroke | X), Pr(Y = drug overdose| X) 이 두 모델을 만들수 있을거에요 Pr(Y = epileptice seziure | X) = 1 - Pr(Y = stroke | X) - Pr(Y = drug overdose| X) 이므로.

클래스가 2개인 (Yes, No) 로지스틱 회귀 모델은 이전 장에서 다루었으니, 이걸 다중 클래스의 경우로 확장시키면 되겠습니다. 하지만 이 방법들은 잘 사용되지 않아요. 왜냐면 다음 장에서 이야기 할 판별 분석 discriminant analysis가 다중 클래스 분류에 널리 사용되고 있거든요. 그래서 로지스틱 회귀를 이용한 다중 클래스 분류에 대해서 자세히 다루지는 않겠습니다.

4.4. 선형 판별 분석 Linear Discriminant Analysis

로지스틱 회귀는 로지스틱 함수로 Pr(Y = k | X = x)를 직접적으로 설계하는 방법이었습니다. 통계적인 용어를 사용하자면 입력 변수(들)이 주어질때 반응 변수 Y에 대한 조건부 분포를 설계 했다고 할수 있어요.

(조건부 확률 분포 모델을 만들어 x가 주어질때 k=1/default인 경우에 대한 확률들을 구하였었음.)

이번에는 이를 대신하는 방법으로 확률들을 약간 간접적으로 추정하는 방법을 다뤄봅시다. 우리는 반응 변수 Y가 주어질떄 입력 X의 분포를 모델링할건데 이걸 베이즈 정리로 뒤집어 Pr(Y = k | X = x)를 추정할거에요. 여기서 확률 분포가 정규 분포라고 가정을 하면 로지스틱 회귀와 비슷한 모델이 될겁니다.

왜 로지스틱 회귀 말고 이런 방법이 필요할까요? 여기에는 다음과 같은 이유들이 있습니다.

- 클래스들이 잘 나누어져있을때, 로지스틱 회귀 모델의 파라미터 추정치는 매우 불안정해요. 선형 판별 분석은 그런 문제가 생기지가 않습니다.

- n이 작고, 각 클래스에 대한 X의 분포가 정규분포라면 선형 판별 분석이 로지스틱 회귀 모델보다 더 안정적이에요.

- 4.3.5장에서 언급했지만 클래스가 2개 이상인 경우 선형 판별 분석이 널리 사용되고 있습니다.

4.4.1 베이즈 정리를 분류에 사용해자 Using Bayes Theorem for Classification

한번 K >=2일때, K개의 클래스 중 하나로 관측치를 분류하고 싶다고 가정해봅시다. 다시 말하자면 질적 반응변수/카테고리 반응 변수 Y는 K개의 구분되고, 순서를 갖지 않는 값을 가지게 되요. $\pi_{k}$를 임의의 관측치가 k번째 클래스에 속할 확률을 사전 확률 prior probability이라고 합시다. 이 확률은 주어진 관측치가 k번쨰 카테고리에 속할 확률을 말해요.

$f_{k}$(x) $\equiv$ Pr(X = x | Y = k)는 관측치가 k번째 클래스에 속할때 X의 밀도 함수라고 합시다. 다시 말하면 $f_{k}$(x)는 k에 속하는 관측치가 X $\approx$ x일 확률이 크다면 확률 밀도 $f_{k}$(x)가 상대적으로 클것이고, k에 속하는 관측치가 X $\approx$ x일 가능성이 낮다면 적을겁니다. 이를 베이즈 정리로 나타내면 아래와 같아요.

이전에 우리가 정의한대로 $p_{k}$(X) = Pr(Y= k | X)로 사용하겠습니다. 이 방식은 4.3.1장에서 $p_{k}$(X)를 직접적으로 계산한것 대신에 추정한 사전확률 $\pi_{k}$와 밀도 함수 $f_{k}$(X)를 식 (4.10)에 대입해서 계산할수 있어요. 일반적으로 사전 확률 $\pi_{k}$는 추정하기 쉬운데, 모집단으로부터 Y의 샘플들을 가지고 있으면 k번째 클래스의 비율로 계산하면 되겠습니다. 하지만 밀도 함수 $f_{k}$(X)를 추정하는건 어떤 단순한 밀도 함수의 형태를 가정하지 않는다면 어렵습니다.

$p_{k}$(x)는 관측치 X = x가 주어질때 k번째 클래스에 속할 확률로 사전 확률 posterior probability이라고 하겠습니다. 이건 관측치의 입력 값들이 주어질때 해당 관측치가 k 클래스에 속하는 확률을 나타내요.

우린 2장에서 배이즈 분류기가 $p_{k}$(X)가 가장 큰 클래스로 관측치를 분류하는 모델로, 모든 분류기들 중에서 에러율이 가장 낮다는걸 봤었습니다. 그러므로 $f_{k}$(X)를 추정할 방법을 찾을수 있으면 우리는 베이즈 분류기에 가까운 분류기를 만들수가 있어요. 이게 이번 장에서 다룰 주제가 되겠습니다.

4.4.2 p = 1인 경우 선형 판별 분석 Linear Discriminant Analysis for p = 1

이번에는 p = 1인 경우 즉 입력 변수가 하나인 경우를 가정하여 살펴보겠습니다. 우리는 $p_{k}(x)를 예측하기 위해서 $식 (4. 10)에다가 대입시킬 $f_{k}$(x)를 추정해서 구하고자 합니다. 그러면 $p_{k}$(x)를 가장 크게 만드는 클래스 k로 분류를 하면 되요. $f_{k}$(x)를 추정하기 위해서 함수적 형태를 가정해야 합니다.

한번 $f_{k}$(x)를 정규, 가우시안 분포라고 가정할게요. 일 차원인 경우 정규 분포는 다음과 같은 형태로 $\mu_{k}$, $\sigma^{2}_{k}$는 k번쨰 클래스에 대한 평균과 분산을 나타낼 거에요. $\sigma^{2}_{1}$ = . . . = $\sigma^{2}_{K}$로 가정하면 K개의 클래스 전체가 분산을 공유한다는 뜻이며, $\sigma^{2}$로 단순화 해서 표기할께요. 이렇게 정리하여 식 (4. 11)을 식 (4.10)에다가 대입시켜 아래와 같이 정리 할 수 있겠습니다.

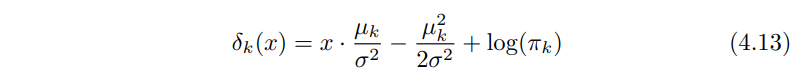

식 (4.12)에서 $\pi_{k}$는 관측치가 k번째 클래스에 속할 사전확률이지 $\pi$ $\approx$ 3.14159가 아닙니다. 베이즈 분류기는 관측치 X = x가 있을때 (4.12)를 최대로 하는 클래스로 분류해줍니다. (4.12)에다가 로그를 취하고 항을 정리하면 클래스 k에 속하는 확률은 아래와 같이 정리할 수 있어요.

K = 2이고 $\pi_{1}$ = $\pi_{2}$인 예시를 들어봅시다. 그러면 베이즈 분류기는 관측치를 2x($\mu_{1}$ - $\mu_{2}$) > $\mu^{2}_{1} $ - $\mu^{2}_{2}$인 경우 클래스 1로 분류할거에요. 그렇지 않으면 클래스 2로 분류 하구요. 이렇게 되면 베이즈 결정 경계 Bayes Decision boundary는 아래의 지점이 됩니다.

이 예시는 그림 4.4의 왼쪽 판낼에서 볼 수 있어요. K = 2이고, 우리는 k에 대한 확률 밀도 함수 $f_{1}$(x)와 $f_{2}$(x)가 정규 분포를 따르고, 두 정규분포를 다르는 확률 밀도 함수가 분산이 동일하다고 가정해서 위와 같은 형태가 나오게 되요. 그리고 이 두 밀도 함수의 평균과 분산 파라미터는 $\mu_{1}$ = -1.25, $\mu_{2}$ = 1.25, $\sigma^{2}_{1}$ = = $\sigma^{2}_{2}$ = 1이 됩니다.

이 두 밀도 함수에는 겹치는 부분이 존재하여 관측치가 어느 클래스에 속하는지 불확실성을 가지고 있어요. 우리가 관측치들이 각 클래스에 속할 확률들이 같다고 가정하면 - $\pi_{1}$ = $\pi_{2}$ = 0.5처럼, 베이즈 분류기는 x < 0이면 관측치를 클래스 1, 아니면 클래스 2로 분류할 수 있을거에요.

지금 경우에는 우리가 X가 각 클래스에 대한 가우시안 분포로부터 샘플링 된걸 알고있으며, 모분산에 대한 파라미터들을 알고있다보니 베이즈 분류기를 계산할 수 있었습니다.

하지만 현실에서는 샘플 X가 각 클래스에 대한 가우시안 분포로부터 샘플되었다고 가정을 하더라도, $\mu_{1}$, . . ., $\mu_{K}$, $\pi_{1}$, .. ., $\pi_{k}$, $\sigma^{2}$같은 파라미터들을 직접 추정해야해요 우리는 모 분산의 성질을 알 수 없으니까요.

선형 판별 분석 LDA은 $\pi_{k}$, $\mu{k}$, $\sigma^{2}$ 추정치들을 식 (4.13)에 대입해서 베이즈 분류기를 근사시키는 방법이에요. 이 추정치들은 주로 아래의 식으로 계산하며 n은 훈련 관측치의 총 갯수이고 $n_{k}$는 k번쨰 클래스에 속하는 관측치의 계수를 나타내요.

$\mu_{k}$ 추정량은 쉽게 k번쨰 클래스에 속하는 모든 관측치들을 평균을 해서 구할수가 있고, $\sigma^{2}$는 각 K클래스에 대한 분산들의 가중치를 고려한 평균으로 볼수 있겠습니다. 그리고 클래스에 대한 사전 지식이 있는 경우 $\pi_{1}$, . . ., $\pi_{K}$를 직접적으로 사용할 수 있어요. 이런 추가적인 정보가 없다면 LDA는 $\pi_{k}$를 k번쨰 클래스에 속하는 관측치의 비율 그러니까 아래와 같이 추정해서 쓸수도 있겠습니다.

LDA 분류기는 식 (4.15), (4.16)을 (4.13)에 대입해서, X = x가 주어질떄 확률이 최대가 되는 클래스로 분류를 해줘요.

이 분류기의 이름에서 선형이란 단어는 식 (4.17)의 판별 함수 $\widehat{\delta}_{k}$가 x에 대한 선형 함수라는 사실에서 따왔습니다.(x에 대한 복잡한 함수의 반대되는 개념)

그림 4.4의 오른쪽 판낼은 각 클래스로부터 얻은 20개의 샘플 데이터의 히스토그램을 보여주고 있어요. LDA를 구현하기 위해서 식 (4.15)와 (4.16)으로 $\pi_{k}$, $\mu_{k}$, $\sigma^{2}$를 추정하고, 그러고나면 검은 직선으로 나오는 결정 경계를 계산할 수가 있어요. 이 결정 경계는 관측치가 가장 큰 확률로 속하는 클래스에 잘 분류되도록 하는 하는 지점이에요(4.17).

이 직선의 좌측에 있는 모든 점들은 녹색 클래스이며 우측에 있는 모든 점들은 보라색 클래스라고 할께요. $n_{1}$ = $n_{2}$ = 20이고, $\widehat{\pi}_{1}$ = $\widehat{\pi}_{2}$일 때, 결정 경계는 두 클래스에 대한 샘플들의 중간 지점인 ($\widehat{\mu}_{1}$, $\widehat{\mu}_{2}$)/2 가 될거에요.

이 그림에서 선형 판별 분석 결정 경계는 최적의 베이즈 결정 경계보다 약간만 왼쪽에 가 있는데 최적의 결과인 베이즈 결정 경계가 ($\mu_{1}$ + $\mu_{2}$)/2인것과는 큰 차이가 나지 않죠. 그러면 얼마나 선형 판별 분석이 잘 수행되었을까요? 이건 시뮬레이션된 데이터이다보니 테스트 관측치를 많이 만들수가 있는데, 그 결과 베이즈 에러율과 LDA 에러율은 각각 10.6%, 11.1%가 되었습니다. 즉 LDA분류기의 에러율은 가장 작은 에러율(베이즈 분류기의 에러율)보다 0.5%밖에 크지 않다는 거에요. 그래서 LDA가 주어진 데이터에 잘 동작한다고 볼 수 있겠습니다.

다시 반복하자면 LDA 분류기는 각 클래스에 속하는 관측치들이 특정 평균 벡터와 공통의 분산 $\sigma^{2}$를 갖는 정규분포로 부터 샘플링되었다고 가정하고, 이 파라미터들을 추정하여 베이즈 분류기에 넣어 주어진 입력이 어떤 클래스에 속하는지 판단하는 방법이라 할 수 있어요. 4.4.4장에서는 k번쨰 클래스의 관측치가 클래스별 분산 $\sigma^{2}_{k}$를 가지는 것을 허용 시킴으로서 덜 견고한 가정을 사용하는 경우를 고민해봅시다.

4.4.3 p > 1인 경우 선형 판별 분석 Linear Discriminant Analysis for p > 1

이번에는 입력 변수가 여러개인 경우로 선형 판별 분석 분류기를 확장시켜봅시다 X = ($X_{1}$, $X_{2}$. . . ., $X_{p}$) 가 다변량 가우시안 분포(다변량 정규 분포)를 따른다고 가정을 하면, 평균 벡터와 공분산 행렬을 가지게 되겠죠. 한번 이 분포에 대해서 간단히 살펴봅시다.

다변량 정규 분포 multivariate gaussian distribution은 각각의 입력 변수들이 일차원 정규 분포를 따른다고 가정하고 있습니다. (4.11)처럼 각 입력벼수 쌍들끼리는 상관관계를 가지고 있구요. 그림 4.5에서 p = 2인 경우 다변량 가우시안 분포의 예시를 볼 수 있는데, 한 지점의 높이는 $x_{1}$와 $x_{2}$가 해당 지점에 있을 확률을 나타냅니다. 두 판낼다 $X_{1}$ 축으로만 보던가 $X_{2}$으로만 보던간에 일차원 정규 분포 형태로 볼 수 있어요.

그림 4.5의 왼쪽 판낼은 Var($X_{1}$) = Var($X_{2}$)인 경우로 Cor($X_{1}$, $X_{2}$) = 0이 됩니다. 이 표면은 종 형태 bell shape 특성을 가지는게 되요. 하지만 두 변수간에 상관관계가 존재한다거나 분산이 같지 않으면 종 형태가 왜곡될수 있는데, 그림 4.5의 오른쪽 판낼에서 볼수 있겠습니다. 이 상황에서 종의 바닥이 원형보다는 타원 형태로 되어있어요.

p 차원 랜덤 변수 X가 다변량 가우시안 분포를 따르는 경우 이를 X ~ N($\mu$, $\Sigma$)로 적을수 있고, 여기서 E(X) = $\mu$는 X의 평균이고, Cov(X) = $\Sigma$는 확률 변수 X에 대한 p x p 개의 공분산 행렬이 됩니다. 이걸 정리하면 다변량 가우시안 밀도 함수는 아래와 같이 정의 할 수 있어요.

p > 1인 경우에 LDA 분류기는 $\mu_{k}$를 클래스별 평균 백터, $\Sigma$는 모든 클래스에 대한 공분산 행렬이라고고 할때 k번째 클래스에대한 관측치는 N($\mu_{k}$, $\Sigma$)인 다변량 가우시안 분포를 따른다고 가정을 하고 있어요. k번째 클래스에 대한 밀도 함수 $f_{k}$(X = x)를 (4.10)에 대입하여 대수적으로 정리를 하면 베이즈 분류기는 관측치 X = x를 아래 식의 결과가 가장 크게 되는 클래스에 속하게 될겁니다. 이 식은 (4.13)의 벡터/행렬 버전이라고 할 수 있어요.

그림 4.6의 왼쪽 예시를 보면 클래스가 3개인 똑같이 나눠진 그림을 보여주고 있는데, 여기서 세 타원은 세 클래스 각각에 95%확률로 속할 범위를 보여주고 있습니다. 점선은 베이즈 결정 경계이구요. 여기서 세 직선은 베이즈 결정 경계로 클래스 1과 클래스 2를 분할하는 직선 하나, 클래스 1과 클래스 3을 분할하는 직선 하나, 클래스 2와 클래스 3을 분할하는 직선 하나로 세 베이즈 결정 경계들이 입력 공간을 3영역으로 분할시켜주고, 관측치가 어느 영역에 속하는지를 보고 관측치를 분류해요.

하지만 우리는 실제로 알수 없는 파라미터들인 $\mu_{1}$, . . ., $\mu_{K}$와 $\pi_{1}$, . . ., $\pi_{K}$, $\Sigma$를 추정해내야 합니다. 이 추정치들은 (4.15)에서 일차원에서 했던것처럼 하면 되요. 그래고 새로운 관측치 X = x가 주어지면 이거를 구한 추정치들을 (4.19)에다가 넣고, $\widehat{\delta}_{k}$이 가장 커지는 클래스에다가 분류 하면 되겠습니다.

여기서 (4.19)의 $\delta_{k}$(x)가 x에 대한 선형 함수의 형태를 가지고 있다 보니 LDA 결정 규칙 decision rule은 x가 각 요소들과 선형 결합에만 의존/영향을 받아 정해지게 되요. 이런 이유로 LDA에서 선형이라는 단어가 사용되고 있습니다.

그림 4.6의 오른쪽 판낼은 세 클래스에 속하는 각각 20개의 관측치들을 보여주고 있어요. 그리고 LDA결정 경계는 직선과 같은 형태로 다오고 있는데, LDA 결정 경계들이 꽤 베이즈 결정 경계에 가까운걸 볼수 있죠. 베이즈와 LDA 분류기의테스트 에러율도 0.0746과 0.0770으로 비슷한걸 알수 있으며 LDA가 이 데이터들을 잘 분류한다고 볼 수 있겠습니다.

그러면 LDA를 채무 불이행 데이터셋에 적용시켜 본다고 할꼐요. LDA모델은 10,000개의 훈련 샘플들을 학습을 했을때 훈련 에러율이 2.75%정도가 나왔는데, 이정도면 꽤 낮다고 볼수 있지만 두가지 주의사항이 있습니다.

- 가장 먼저, 훈련 에러율인 일반적으로 테스트 에러율보다 낮습니다. 다시 말하면 이 분류기는 새로운 데이터를 예측할때 성능이 더 떨어지게 될거라는 말인데 이 이유는 훈련 데이터셋만 보고 파라미터들을 조정했기 때문이에요. 파라미터의 개수 p와 샘플 개수 n의 비율이 커질수록 오버피팅될 가능성이 더 높아 집니다. 하지만 이 경우에는 p = 2이고, n = 10, 000이다보니 그럴 문제는 없을거에요.

- 두번째로 훈련데이터의 3.3%만 채무 불이행이 되었다보니, 사람의 카드 대금이나 학생 여부를 고려하지 않더라도 디폴트가 되지않았다고 하는 널분류기또한 훈련 에러율이 3.3%가 나올거에요. 다시 말하면 널 분류기가 LDA 훈련 에러율 2.75보다 훈련 에러율 3.3으로 약간만 높게 나옵니다.

이후에는 혼동 행렬과 ROC커브 등에 나오나 시간 관계 상 생략

4.4.4 이차 판별 분석 Quadratic Discriminant Analysis

지금까지 각 관측치들이 다변량 가우시안 분포를 따른다고 가정하는 LDA에 대해서 살펴봤었습니다. 이차 판별 분석 Quadratic discriminant analysis (QDA)는 이를 대신할수 잇는 방법인데, LDA와 마찬카지로 QDA 분류기도 각 클래스에 속하는 관측치들이 가우시안 분포를 따른다고 가정을하고, 파라미터 추정치를 베이즈 정리에 대입하여 예측을 하고 있어요.

하지만 LDA와 다르게 QDA는 각 클래스가 고유의 공분산 행렬을 가지고 있다고 가정을 해서 각 클래스에대한 관측치는 X ~ N($\mu_{k}$, $\Sigma_{k}$)를 따른다고 봅니다. 여기서 $\Sigma_{k}$는 k번쨰 클래스의 공분산 행렬을 나타내요. 이 가정에 따라서 베이즈 분류기는 X = x가 아래의 $\delta_{k}$(x)를 가장 크게 하는 클래스로 분류하게 되요.

그래서 이차 판별 분석 분류기는 $\Sigma_{k}$, $\mu_{k}$, $\pi_{k}$를 추정해서 (4.23)에 대입하여 분류기를 만들고, 관측치 X =x가 가장 크게 하는 클래스로 분류를 시켜요. (4.19)와 다르게 (4.23)은 x에 대한 이차 함수의 형태로 나타나다보니 QDA가 이차 판별 분석이라는 이름을 가지게 되었습니다.

K개의 클래스가 공통 공분산을 가진다(선형 판별 분석) 혹은 가지지 않는다(이차 판별 분석)이란 가정이 왜 중요한 건가요? 다시 말하면 어쩔때 LDA가 좋고, QDA가 좋은걸가요? 이에 대한 대답은 편향 분산 길항 관계에 달려있습니다. p 개의 입력 변수들이 있을때 공분산 행렬을 추정하기 위해서는 p(p+1)/2개의 파라미터들이 필요로해요.

QDA는 각 클래스에 대해 개별적인 공분산 행렬을 추정하다보니 총 K p(p + 1) / 2개의 파라미터들이 필요하죠. 50개의 입력변수가 주어진 경우 1,275개의 아주 많은 파라미터들이 사용될거에요. 그래서 K 클래스가 같은 공분산 행렬을 공유한다고 가정 함으로서, LDA 모델은 x에 대해 선형적인 형태가 되어 추정하는데 Kp개의 선형 계수들만 사용하면 됩니다.

결과적으로 LDA는 QDA보다 덜 유연한 분류기이고, 적은 변동을 다룰수 있지만 예측 성능(여기서 말하는건 정확도보다는 속도를 말하는것 같음)를 개선할수 있지만 이건 길항 관계/상쇄 관계가 있어요. K 클래스가 공통 공분산을 가진다는 LDA의 가정이 올바르지 않은 경우에는 LDA가 편향이 심하게 나와 성능이 떨어지겠죠.

다시말하면 LDA는 훈련 관측치가 적고, 다뤄야 할 분산들을 줄이는게 중요한 경우에 LDA가 QDA보다 더 나은 선택이라고 할수 있어요. 반대로 훈련 데이터셋이 아주 크고, 분류기의 변량이 중요한 문제가 아니거나 K 클래스의 공통 공분산을 사용해서는 안되는 경우 QDA를 사용하는게 좋습니다.

그림 4.9는 두가지 시나리오에서 LDA와 QDA의 성능을 보여주고 있습니다. 좌측 그림은 두 가우시안 클래스가 $X_{1}$, $X_{2}$ 사이에 0.7의 공통 상관관계를 가지고 있는 경우를 보여주고 있는데, 여기서는 베이즈 결정 경계가 선형이다보니 LDA 결정 경계가 더 잘 근사시키고 있어요. 하지만 QDA 결정 경계는

반대로 우측 그림은 오랜지색 클래스는 변수간의 상관 관계가 0.7이고, 파란색 클래스는 -0.7의 상관 관계를 갖는 경우를 보여주고 있는데, 여기선 베이즈 결정 경계가 이차적이다보니 QDA가 LDA보다 더 정확하게 이 경계를 근사시키고 있죠.

'번역 > 통계적학습법개론' 카테고리의 다른 글

| [통계기반학습개론] 5.1.2 LOOCV 하나만 가지고 교차검증, 5.1.3 K-폴드 교차 검증 (0) | 2021.03.01 |

|---|---|

| [통계기반학습개론] 4.5 분류 기법들 비교하기와 5. 리샘플링 방법 (0) | 2021.02.23 |

| [통계기반학습개론] 4. 분류 Classification 와 로지스틱회귀모델 (0) | 2021.02.19 |

| [통계기반학습개론] 3.4 마케팅 전략/3.5 KNN과 선형 회귀 모델 비교 (0) | 2021.02.06 |

| [통계기반학습개론] 3.2.2 & 3.3 회귀 모델에 대한 중요한 질문들과 다른 고려사항들 (0) | 2021.02.06 |