728x90

Gradient Descent (C1W2L04)

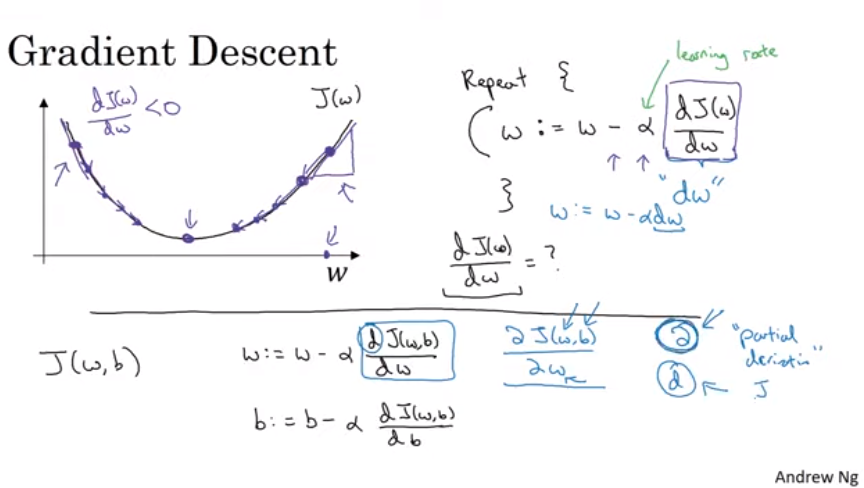

경사 하강

- 손실 함수 : 단일 훈련셋이 잘 예측되었는지, 비용 함수 : 전체 셋이 잘 예측되었는지 (매개변수 w, b 를 잘 학습하여)

- J(w, b)를 최소화 하는 w, b를 찾아야 함.

* w는 보통 더 큰 차원을 가지나 이 예시에서 w, b를 하나의 실수로 봄.

* 여기서 함수 J(w, b)는 컨벡스 함수로 비용 함수로 사용할 수 있음.

- 경사 하강법을 통해서 초기화 지점으로부터 전역적 최저점까지

경사 하강

- w에 대한 차원으로 보자

- w := w - alpha * d J(w)/ dw

- alpha : 학습률

- dw = d J(w) / dw, 미분 계수, 비용 함수 값에 대한 w의 기울기

=> w := w - alpha dw

- 미분 계수는 w의 위치에 따라 양수나 음수가 되어 w를 증가시키거나 감소시켜 전역적 최적점에 도달함.

- d는 일변수 함수에 대한 미분시 사용.

- 코드 구현시 관습적으로 미분계수를 dw, db와 같이 표기

300x250

'컴퓨터과학 > 딥러닝 AI Andrew Ng' 카테고리의 다른 글

| TensorFlow2 API로 모델 설계 방법 예시 (0) | 2021.04.21 |

|---|---|

| C1W2L05, C1W2L06 Derivatives, More Derivative Examples (0) | 2021.04.21 |

| C4W2L06 Inception Network Motivation (0) | 2021.04.21 |

| C4W2L05 Network In Network (0) | 2021.04.21 |

| C2W1L01 Train/Dev/Test Sets (0) | 2021.04.20 |